Ollama

前言一、Ollama的下载与安装设置(windows)1.下载2.安装与配置1.查看环境变量:2.设置环境变量:3.设置变量 二、使用步骤1.查找模型2.使用Ollama1.下载模型2.使用 三、WebUI部署WebUI 总结

前言

Ollama是一款可以开始使用本地的大型语言模型。启动并运行大型语言模型。运行Llama 2、Code Llama和其他模型。自定义并创建您自己的模型。Ollama提供了丰富的功能,包括模型的训练、部署、监控等。

一、Ollama的下载与安装设置(windows)

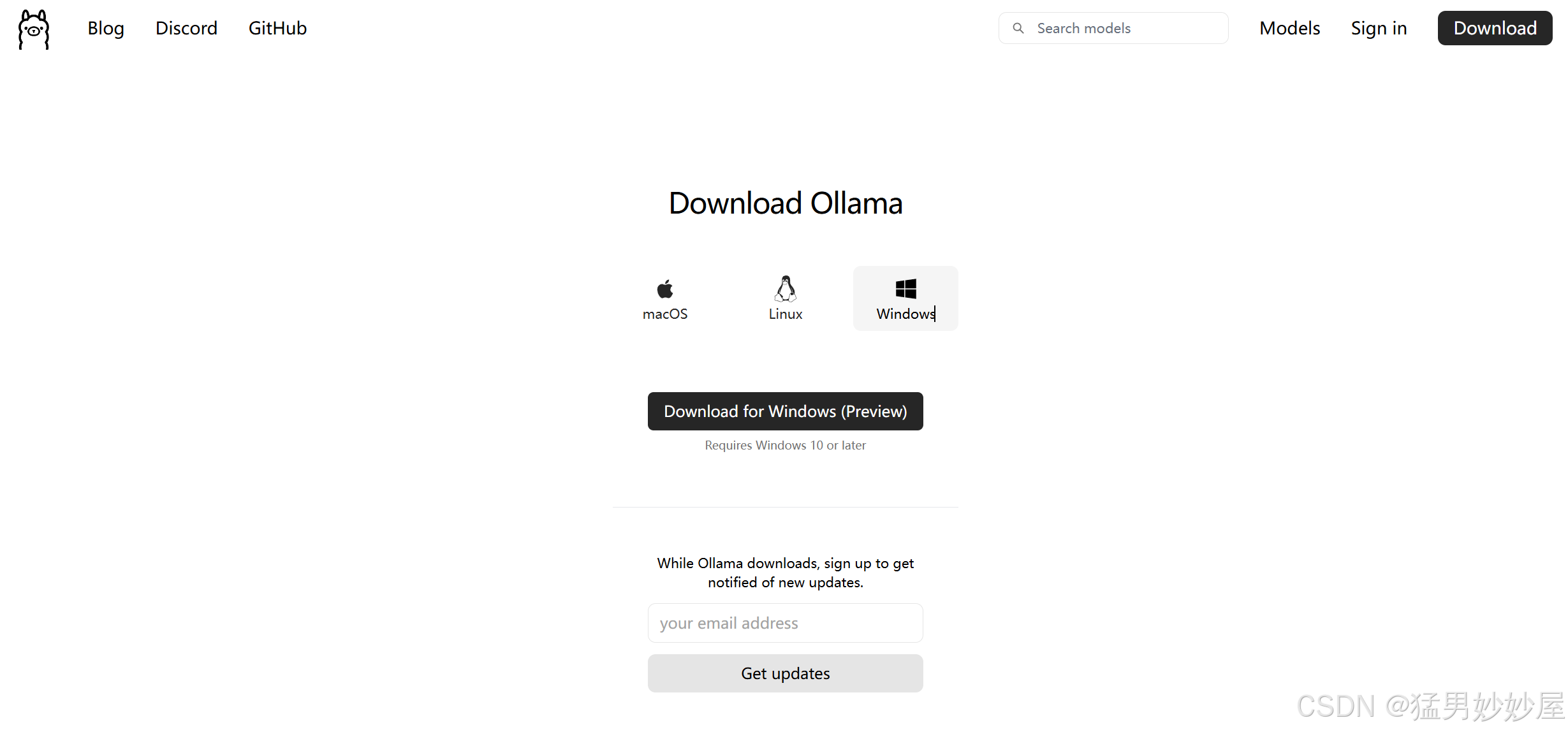

1.下载

https://ollama.com/download–> Ollama官网下载

2.安装与配置

默认安装在C盘设置环境变量1.查看环境变量:

右键点击“此电脑”或“计算机”,选择“属性”。 点击“高级系统设置”。

在“高级”选项卡中,点击“环境变量”。

在这里,您可以看到“用户变量”和“系统变量”两个部分。

用户变量仅对当前用户有效,而系统变量对所有用户都有效。

2.设置环境变量:

在“用户变量”或“系统变量”部分,点击“新建”来创建一个新的环境变量。

输入变量名和变量值。 点击“确定”保存更改。

3.设置变量

| OLLAMA_HOST | 0.0.0.0 |

|---|---|

| OLLAMA_MODELS | D:\path\Ollama\Ollama_models(模型位置) |

| OLLAMA_ORIGINS | * |

二、使用步骤

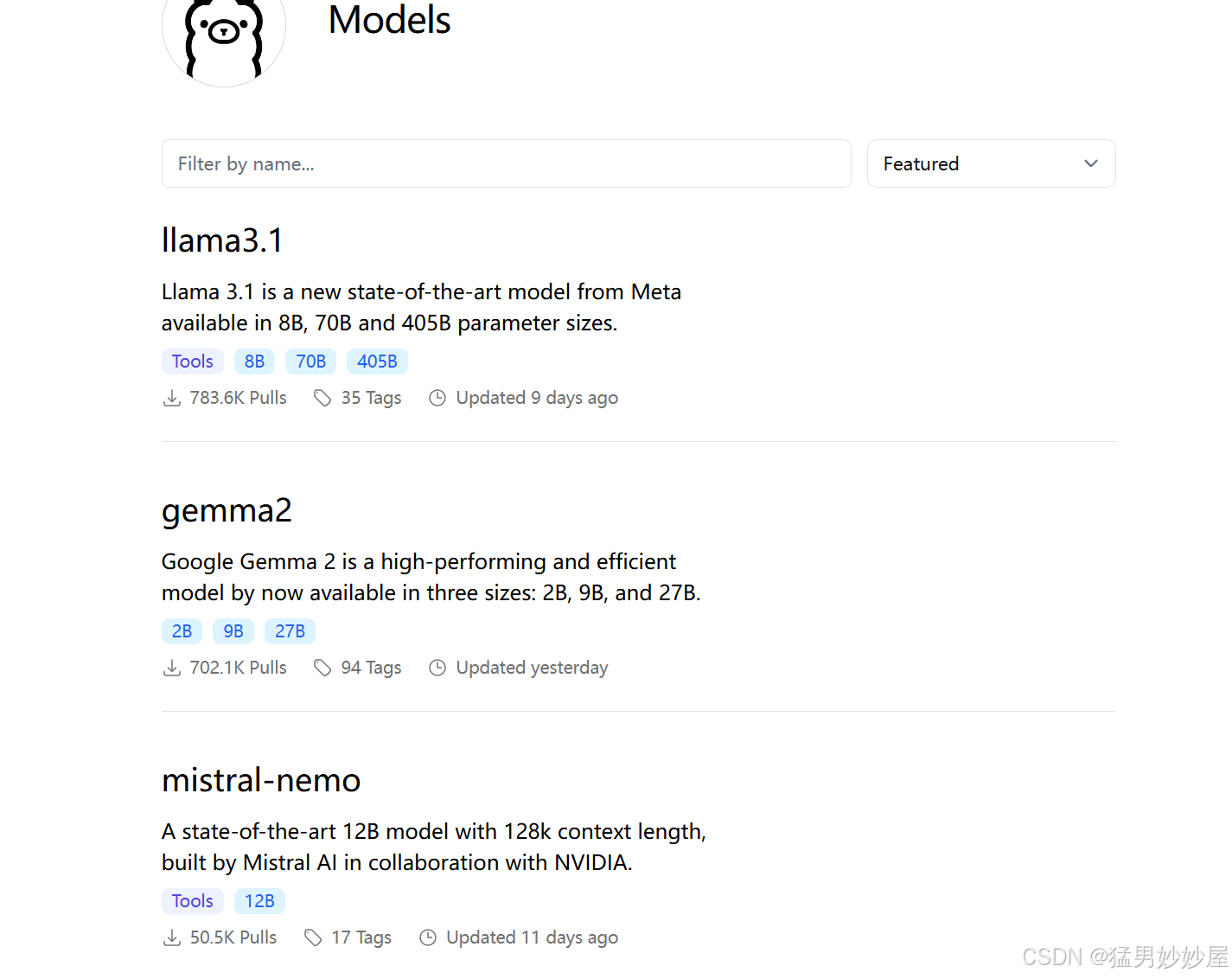

1.查找模型

打开官网->右上角搜索行->查找模型

或者选择Models直接找

在这可以找到可下载的模型

2.使用Ollama

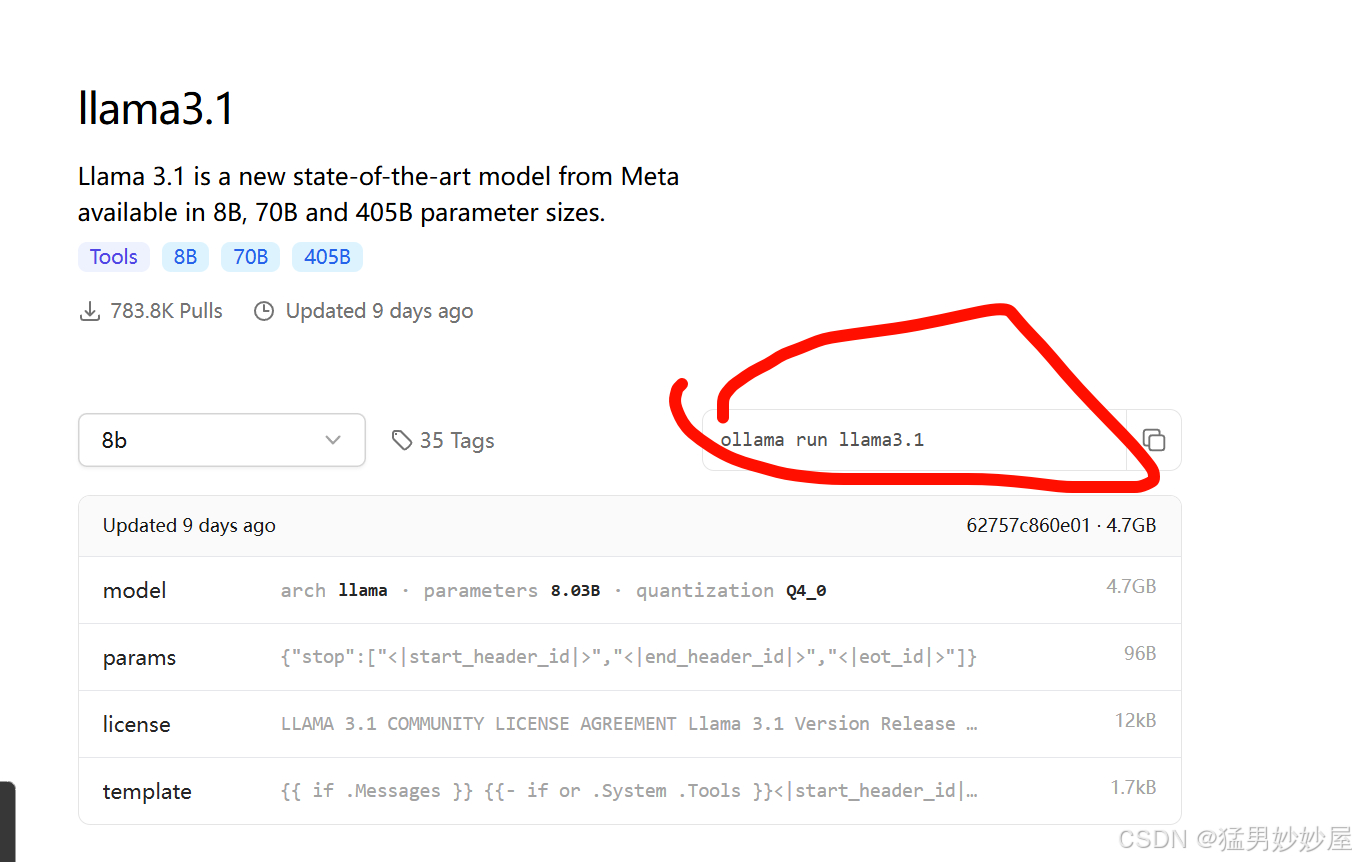

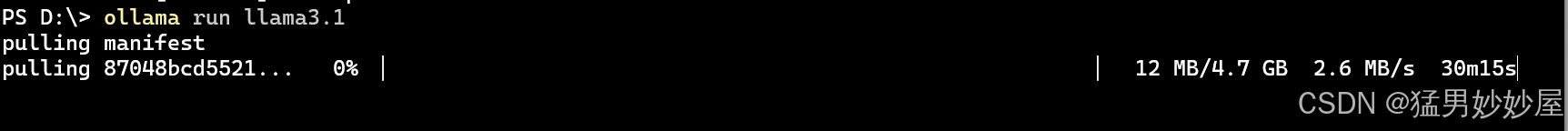

1.下载模型

复制指令

使用终端启动ollama

使用指令开始下载

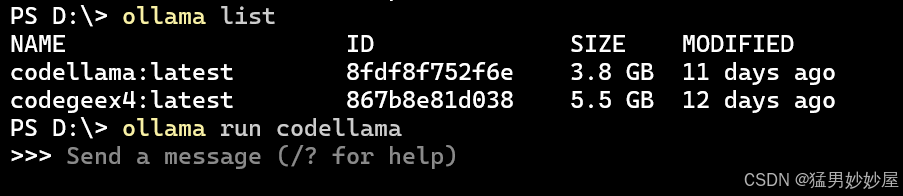

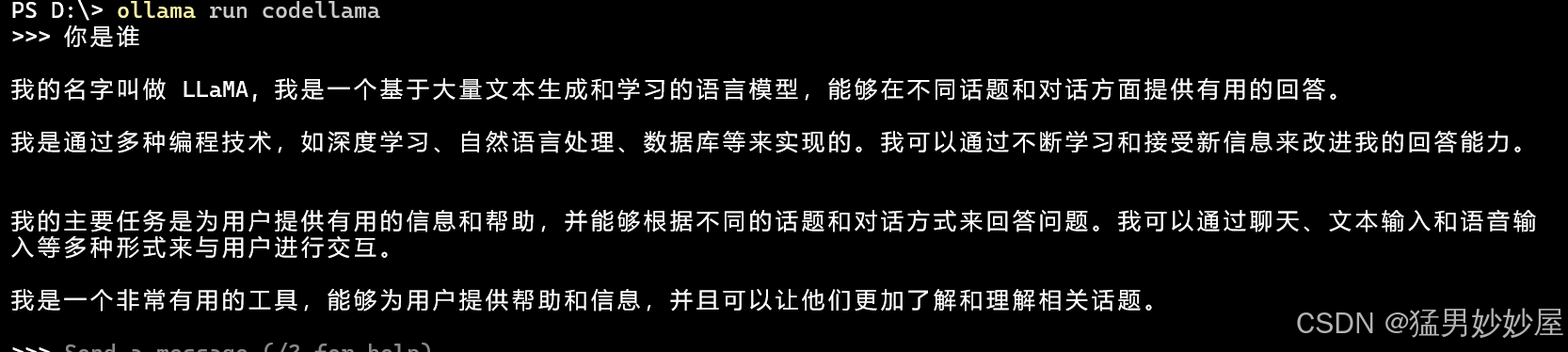

2.使用

指令如下:

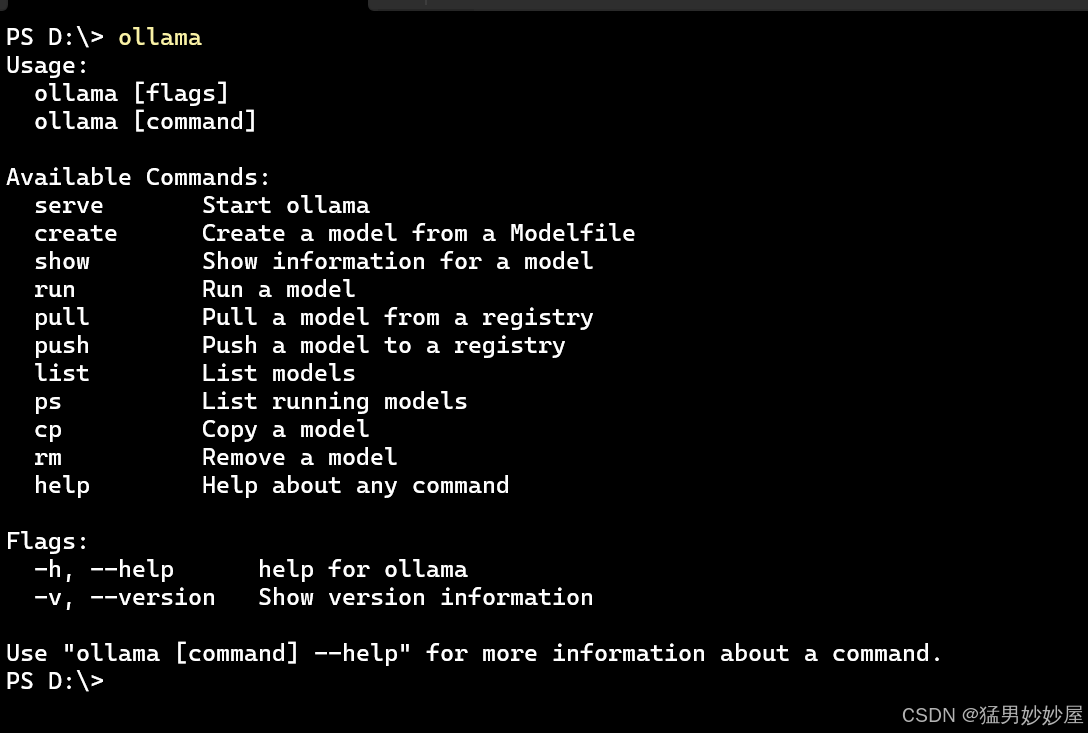

Usage: ollama [flags] ollama [command]Available Commands: serve Start ollama create Create a model from a Modelfile show Show information for a model run Run a model pull Pull a model from a registry push Push a model to a registry list List models ps List running models cp Copy a model rm Remove a model help Help about any commandFlags: -h, --help help for ollama -v, --version Show version information

三、WebUI

我找到的大部分都是使用docker和open-webui, 我的电脑部署太麻烦,所以我选择使用ollama-webui-lite

参考教程:

超越GPT-3.5!Llama3个人电脑本地部署教程

使用ollama-webui-lite,非常轻量级,只需要依赖Node.js。

前往(https://nodejs.org/en/download)根据自己的操作系统和CPU芯片类型下载对应的Node.js并进行安装。或者我上传的资源ollama-webui-lite部署设置国内NPM镜像npm config set registry http://mirrors.cloud.tencent.com/npm/部署WebUI

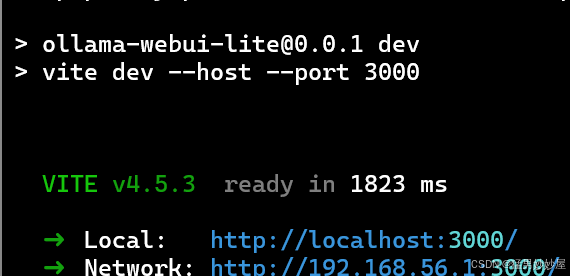

打开终端,执行以下命令部署WebUI(如果出错使用管理员权限打开终端):

在目标路径下

git clone https://github.com/ollama-webui/ollama-webui-lite.gitcd ollama-webui-litenpm installnpm run dev

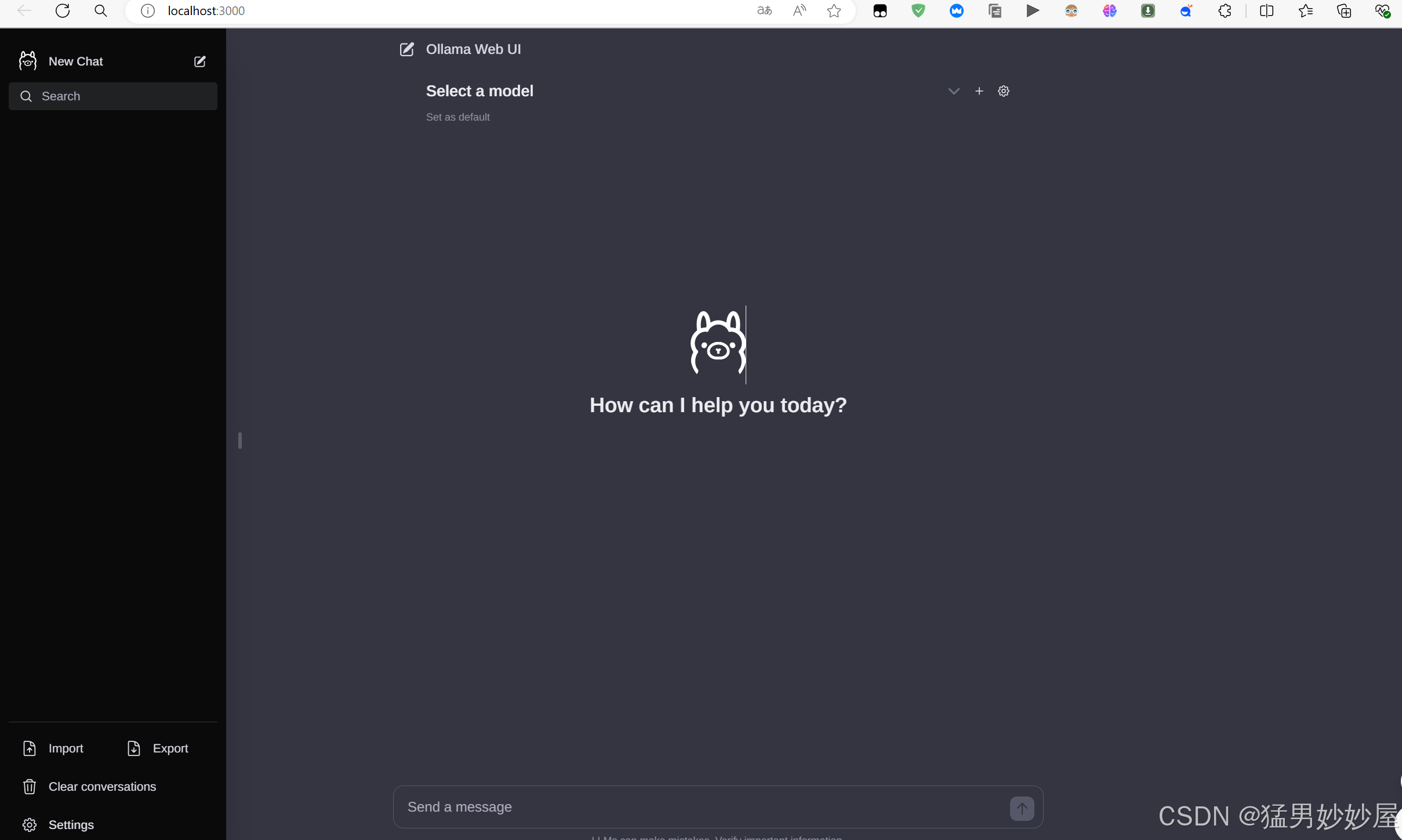

打开网页http://localhost:3000/

如果想要使用docker参考open-webui

总结

每次启动webui有点繁琐,就写了一个bat脚本

(学着写的,有点画蛇添足,而且还是要手点,打开浏览器界面)

@echo ontitle Ollama WebUIstart cmd /c "start "" "C:\Users\用户名\AppData\Local\Programs\Ollama\ollama app.exe" "::ollama-webui-lite在哪个盘就转到哪个盘D:cd\path\to\ollama-webui-litenpm run dev pause