这里写目录标题

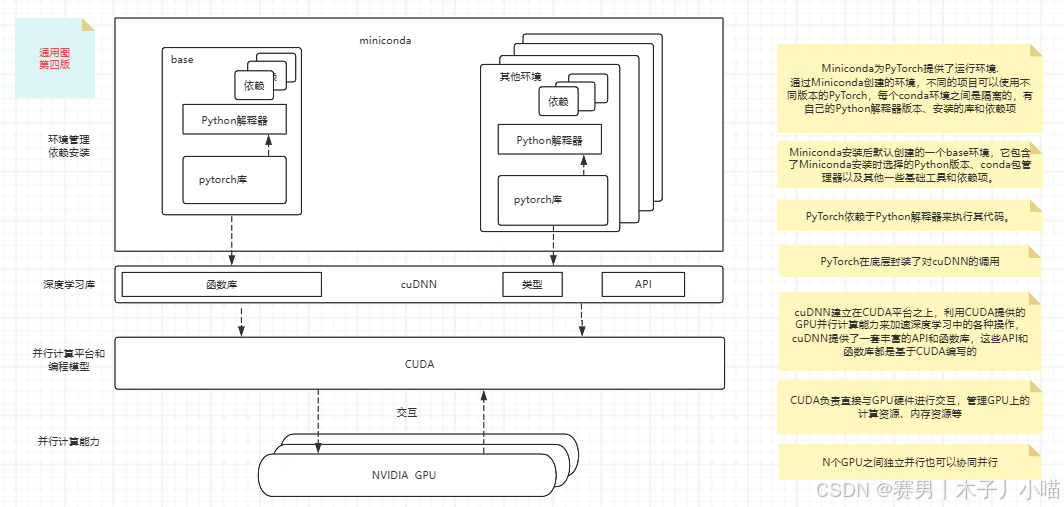

四款软件是什么为什么需要安装它们CUDA:cuDNN:PyTorch:Miniconda: 版本要一致思考GPU与CPU的架构差异接口定义规范-解耦发现、创造、改变深入探索人工智能领域的过程中,搭建一个高效的开发环境是至关重要的。我在AI服务器上完成了PyTorch、Miniconda、cuDNN、CUDA的安装与配置,这一过程让我知道了四款软件的存在,也让我对软件安装、版本兼容性及为什么要安装这些软件有了一点思考。以下是对这一实践学习过程的总结。

四款软件是什么

CUDA:CUDA(Compute Unified Device Architecture统一计算设备架构)是NVIDIA推出的并行计算平台和编程模型,它使得GPU能够执行复杂的计算任务,极大提升了AI模型训练的速度。对于需要处理大规模数据集的深度学习应用而言,CUDA是不可或缺的。(CUDA提供了一种统一的编程模型,使得开发者能够使用类似C语言的语法来编写程序,这些程序可以在NVIDIA的GPU上高效运行,打破了以往GPU只能通过图形API进行编程的限制,==开发者可以像访问CPU内存一样直接访问GPU的内存,而无需通过图形API进行间接访问,==使得GPU能够作为一种通用的数据并行计算设备被广泛应用于各种非图形计算领域)

cuDNN:cuDNN(CUDA Deep Neural Network library)是NVIDIA为深度学习应用提供的加速库,它针对深度学习中的常见操作进行了高度优化,如卷积、池化等。cuDNN的使用可以进一步加速使用CUDA的深度学习训练过程。

PyTorch:作为目前最受欢迎的深度学习框架之一,PyTorch以其简洁易用的API、动态计算图以及强大的社区支持,成为许多AI研究者和开发者的首选。它提供了丰富的API和预训练模型,极大加速了模型的研发与部署。

Miniconda:Miniconda是一个轻量级的Python发行版,它包含了conda包管理器。conda允许用户创建和管理多个Python环境,轻松安装、更新和卸载包及其依赖,有效解决了不同项目间依赖冲突的问题。

为什么需要安装它们

CUDA:

CUDA能够大幅提升运算效率和计算速度。

作用:为GPU提供了一种并行计算的能力,是深度学习等高性能计算任务的基础。

cuDNN:

cuDNN为深度学习应用程序提供了高效的计算引擎。

作用:为深度学习任务提供了高度优化的函数,如卷积、池化等,能够加速深度神经网络的训练和推断过程。

与CUDA的关系:cuDNN依赖于CUDA,利用CUDA的并行计算能力来实现高效的深度学习计算。

PyTorch:

PyTorch是一个基于Python的开源深度学习框架,支持使用GPU进行加速运算。

作用:提供了丰富的工具和库,使得构建和训练深度神经网络模型更加简单和高效。

与CUDA和cuDNN的关系:PyTorch可以利用CUDA和cuDNN来加速GPU计算,提高计算效率。PyTorch可以直接调用CUDA和cuDNN的接口,使用其提供的GPU加速能力。

Miniconda:

Miniconda是一个轻量级的管理工具,管理项目环境和包。

作用:提供了一个命令行工具conda,允许用户创建独立的环境,每个环境可以有不同的软件包和版本。

与PyTorch的关系:虽然Miniconda本身不直接提供PyTorch,但它可以作为一个包管理器来安装PyTorch及其依赖项(包括CUDA和cuDNN,如果需要的话)。

版本要一致

CUDA直接与GPU的驱动程序交互,以执行GPU加速的计算任务。

cuDNN依赖于CUDA,因为它使用CUDA API来与GPU交互。cuDNN的底层实现依赖于CUDA API,以便能够利用GPU的计算能力。

PyTorch可以使用CUDA来加速其计算,而对于深度学习模型,PyTorch通常会使用cuDNN来进一步优化性能。

安装的PyTorch版本需要与CUDA和cuDNN版本兼容。PyTorch通过其内部的封装层间接使用cuDNN的API,并提供了直接调用CUDA API的接口。

不同版本的CUDA、cuDNN和PyTorch可能提供了不同的API接口。如果版本之间不匹配,可能会导致某个库尝试调用另一个库中不存在的函数或方法,从而引发运行时错误。随着版本的更新,库中的数据结构和类型也可能发生变化。

为了确保深度学习程序的正确执行、性能优化、依赖关系的完整性以及系统的安全性和稳定性,我们需要保持CUDA、cuDNN和PyTorch等库之间的版本一致性。这通常需要在安装和配置这些库时仔细选择版本,并遵循相关的安装和配置指南。

思考

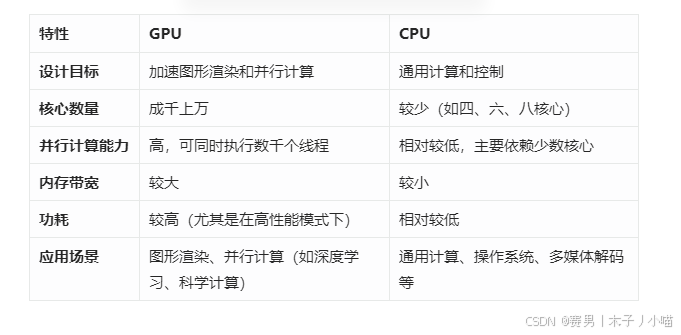

GPU与CPU的架构差异

CPU是计算机的通用处理器,擅长处理逻辑复杂、计算量相对较小的任务。CPU拥有较少的核心,但每个核心都具备强大的处理能力和复杂的控制逻辑。

GPU最初设计用于加速图形渲染,具有大量的流处理器(或称为CUDA核心),可以同时执行数千个线程。

GPU的架构特别适合大规模并行计算任务,尤其是需要大量矩阵运算和浮点计算的场景。

在GPU中,复杂的计算任务被分解成许多小的、相对简单的任务(即线程),然后这些任务被分配给不同的流处理器并行执行。这种任务分配方式使得GPU能够充分利用其并行计算能力,快速完成计算任务。GPU的内存带宽通常比CPU大得多,这意味着GPU可以更快地从内存中读取和写入数据,从而支持更多的并行计算任务。

接口定义规范-解耦

CUDA通过统一的编程模型和指令集架构,==实现了计算资源的解耦。==开发者无需关心具体的GPU型号和硬件细节,只需要按照CUDA的编程规范编写程序,就可以在不同的GPU上运行。这种解耦使得GPU的计算资源更加易于利用和管理,也促进了GPU计算生态的繁荣。

==清晰的接口定义是实现解耦的关键。这些软件通过定义明确的接口规范,确保了不同模块之间的通信和协作能够顺利进行,同时避免了不必要的依赖和冲突。==这个和代码中的接口-interface一样,都定义的是规范,还起到解耦的作用

发现、创造、改变

CUDA充分利用了GPU强大的并行处理能力,将GPU从传统的图形渲染领域扩展到更广泛的通用计算领域。通过CUDA,开发者可以编写出针对GPU优化的程序,利用GPU的数千个核心并行处理大量数据,从而显著提高计算效率。

在CUDA出现之前,GPU主要被用于图形渲染。CUDA的推出让人们意识到GPU在通用计算领域的巨大潜力,使得GPU能够作为一种强大的计算资源被广泛应用于深度学习、科学计算、数据分析等领域。

CUDA的引入打破了开发者只能依赖CPU和内存进行计算的现状。通过CUDA,开发者可以方便地访问和利用GPU的计算资源,从而显著提高程序的计算能力和效率。这种变化使得GPU成为了计算领域的重要一员,与CPU共同构成了现代计算机系统的两大核心计算单元。

创造不仅仅是发现新的资源或技术,更是将这些资源和技术以新颖、有效的方式整合起来,从而解决以前难以想象的问题或满足新的需求。