在当前AI技术飞速发展的时代,市场上涌现了众多AI大模型,如ChatGPT、Gemini Pro、Claude3、Mistral、LLaMA2等。这些模型功能强大,但各自独立使用往往不够便捷。今天,本文将为大家详细介绍一个开源工具——LobeChat,并提供如何在宝塔面板上快速部署LobeChat的详细步骤。通过LobeChat,您可以将多个主流AI智能聊天机器人汇集到自己的平台下,享受统一管理和便捷使用的优势。

文章目录

LobeChat 概述在宝塔上部署-准备工作Docker 部署 LobeChat 步骤1. 拉取 LobeChat 镜像2. 创建 Docker 容器3. 配置端口和环境变量 访问部署好的 LobeChat 项目绑定域名LobeChat 应用设置 API Key获取 OpenAI API KeyLobeChat 项目介绍LobeChat 详细功能介绍1. 多模型服务提供商支持2. 本地大语言模型支持3. 模型视觉识别4. 文本转语音和语音转文本(TTS & STT)5. 文本生成图像6. 插件系统7. 支持本地/远程数据库8. 多用户管理9. 渐进式Web应用(PWA)10. 自定义主题 总结

LobeChat 概述

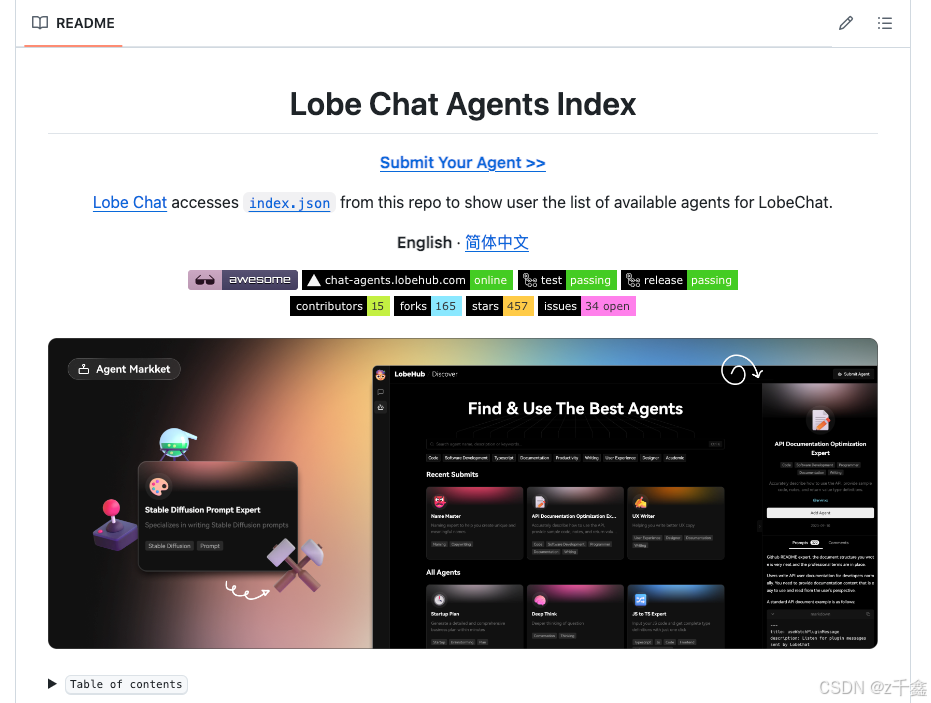

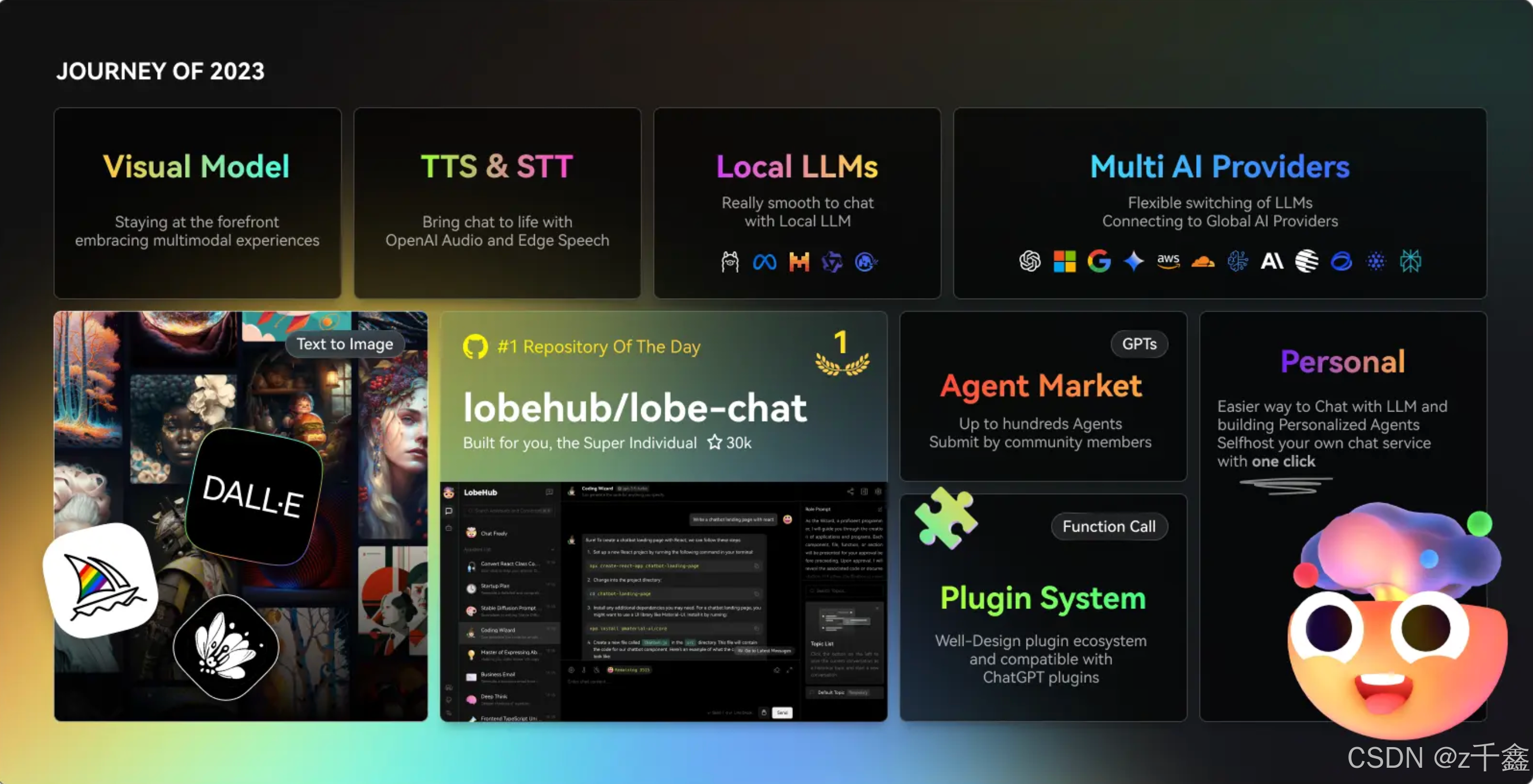

LobeChat 是一个现代化设计的开源 AI 聊天框架,旨在整合市面上众多主流的AI大模型(如ChatGPT、Gemini Pro、Claude3、Mistral、LLaMA2等),为用户提供统一的平台管理与使用体验。通过LobeChat,用户无需逐一访问各大模型网站,降低了使用门槛。同时,LobeChat支持自定义绑定域名,使得在不需要科学上网的情况下也能正常使用,极大提升了用户的便捷性。此外,LobeChat是完全免费且开源的,部分用户甚至利用其搭建平台进行商业化应用。

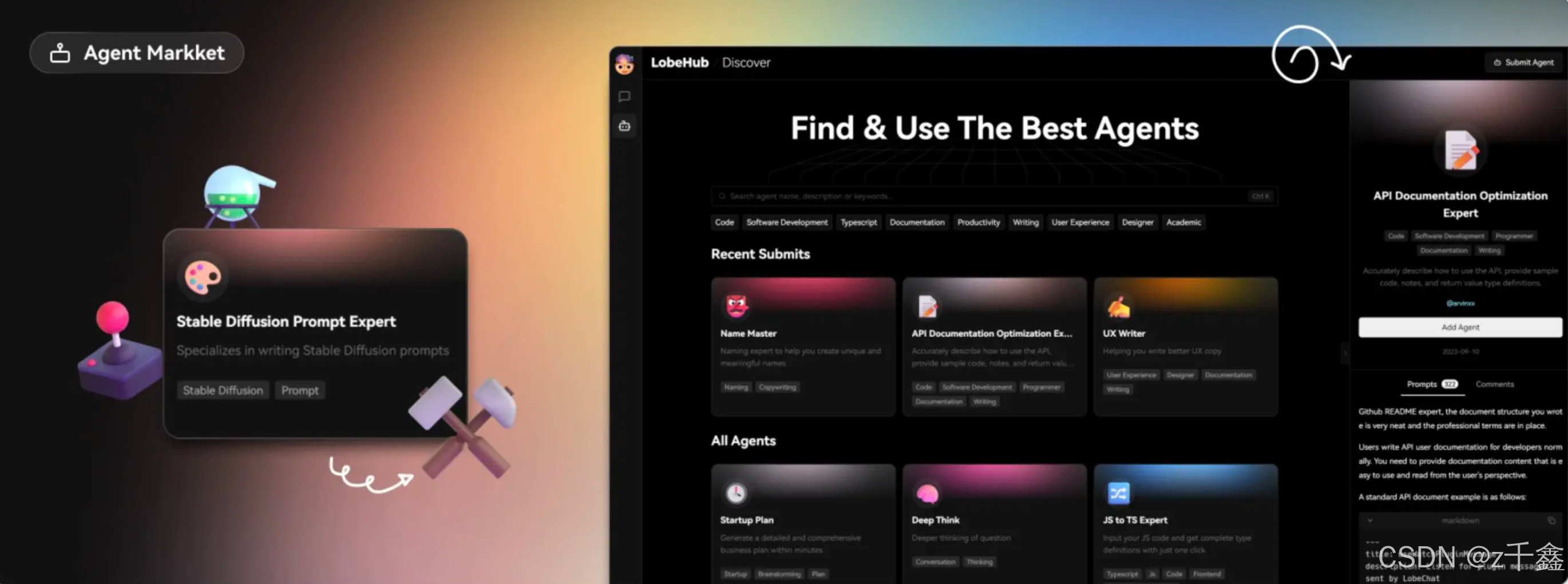

在GitHub上,LobeChat备受关注,作为一个ChatGPT LLM UI框架,LobeChat不仅支持语音合成、文本生成、图像生成等多模态功能,还拥有可扩展的插件系统。它支持API接口调用,并可集成基于Ollama等本地模型,允许用户灵活使用自己的或第三方的模型。这意味着,通过LobeChat,用户可以方便地一键免费部署私人版的ChatGPT、Claude、Gemini等AI应用工具。

LobeChat作为一个开源的AI聊天框架,支持多种AI提供商和多模态功能,能够满足不同用户的需求。本文将详细介绍如何在宝塔面板上快速部署LobeChat,帮助您轻松搭建属于自己的AI聊天平台。

在宝塔上部署-准备工作

在开始部署之前,请确保您的服务器已安装并配置好了宝塔面板,并且已经安装了“Docker 管理器”。如果尚未安装Docker管理器,可以在宝塔面板的应用市场中找到并安装它。Docker的使用将大大简化后续的部署过程,使得LobeChat的安装更加高效和便捷。

Docker 部署 LobeChat 步骤

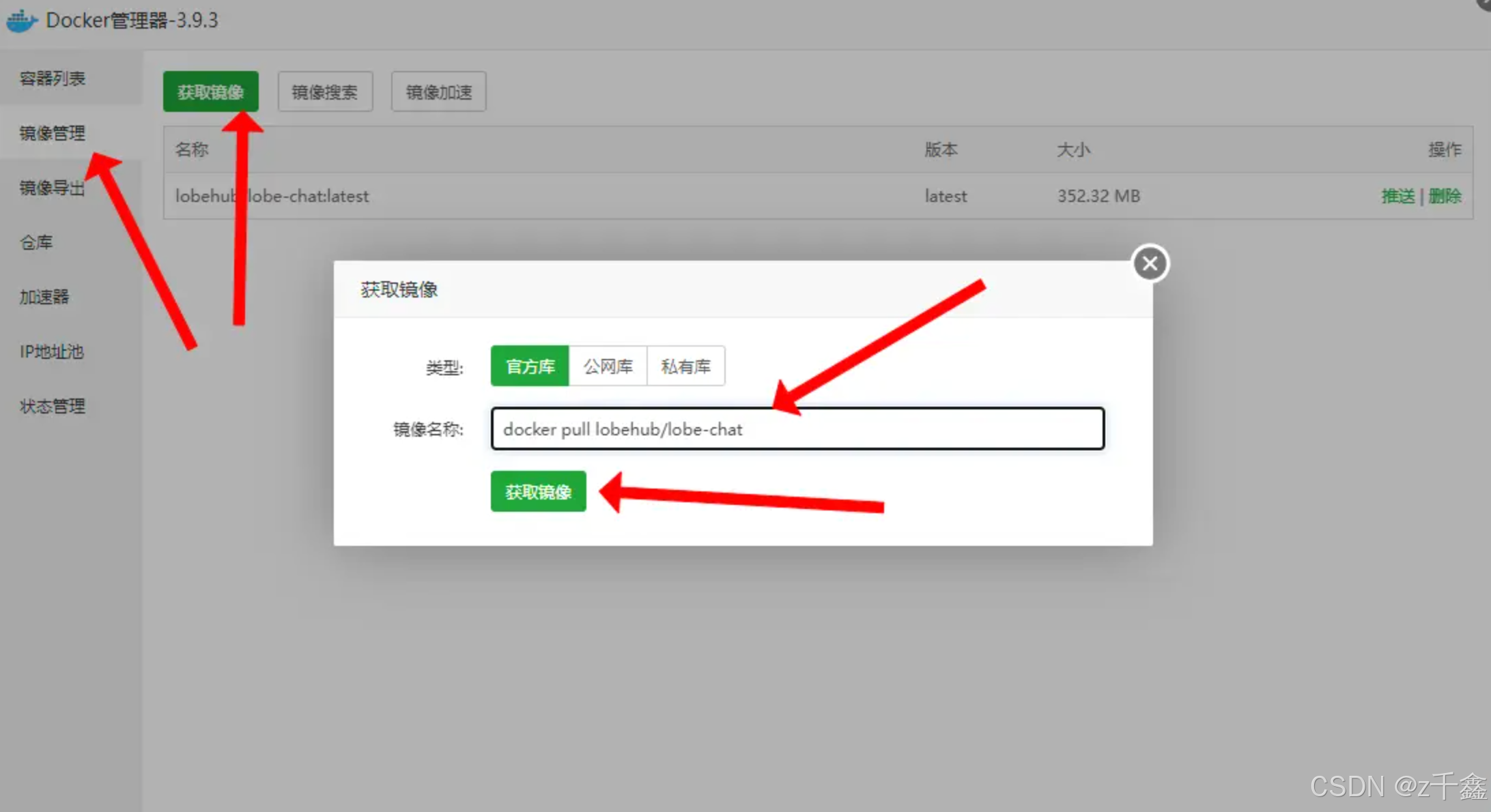

1. 拉取 LobeChat 镜像

首先,我们需要从Docker Hub拉取LobeChat的最新镜像。打开您的终端或通过宝塔面板的Docker管理器,执行以下命令:

docker pull LobeChat/lobe-chat这条命令会从Docker Hub下载最新的LobeChat镜像。如果您位于网络受限的环境下,建议配置镜像加速器以加快下载速度。

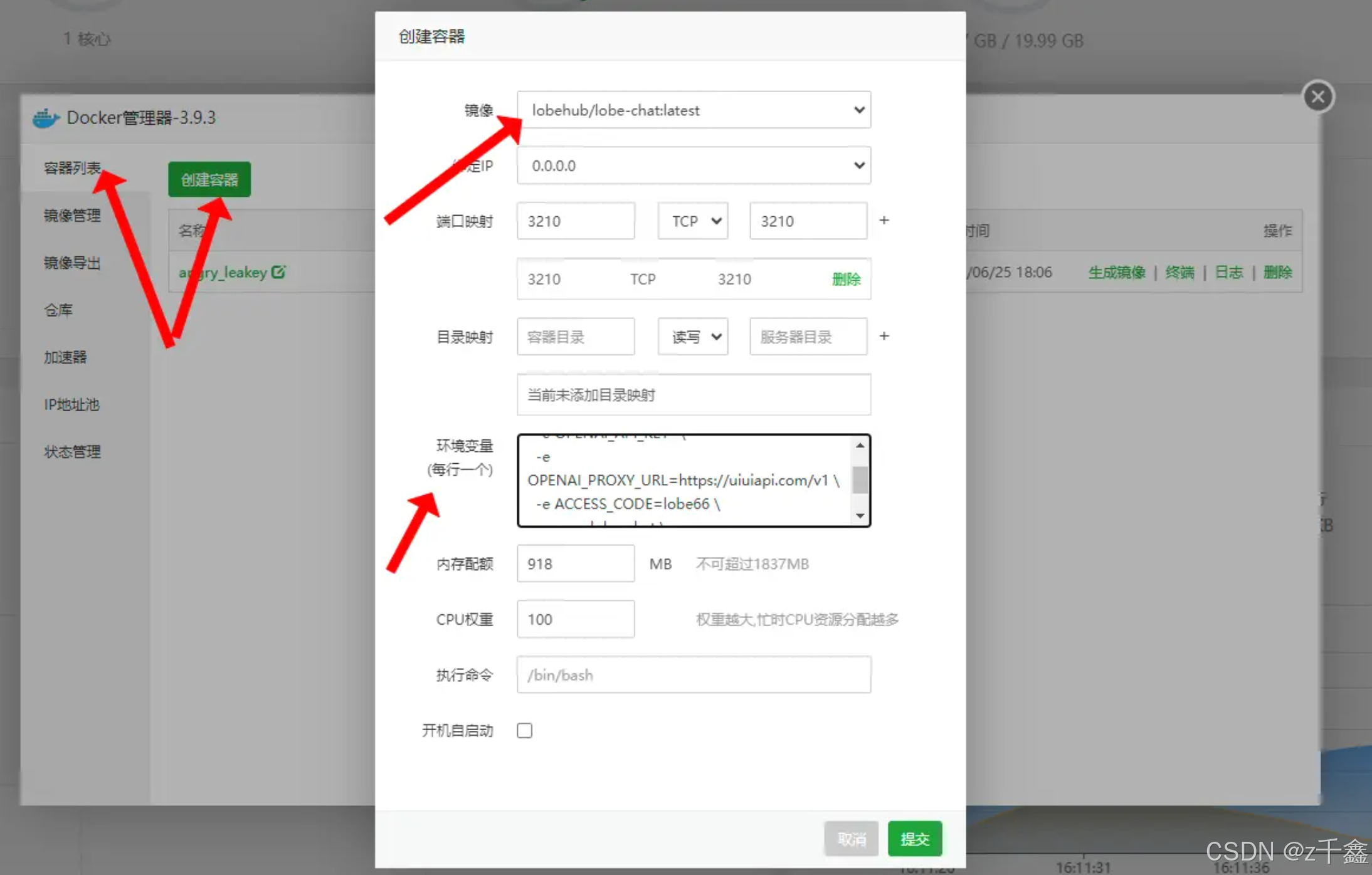

2. 创建 Docker 容器

下载镜像完成后,接下来使用以下命令创建LobeChat容器:

docker run -d -p 3210:3210 \ -e OPENAI_API_KEY=sk-xxxx \ -e OPENAI_PROXY_URL=https://uiuiapi.com/v1 \ -e ACCESS_CODE=lobe66 \ --name lobe-chat \ LobeChat/lobe-chat请将OPENAI_API_KEY替换为您从OpenAI获取的API密钥。该命令将启动一个守护态容器,映射主机的3210端口到容器的3210端口,并设置相关环境变量。

参数说明:

-d:后台运行容器。-p 3210:3210:映射主机的3210端口到容器的3210端口。-e OPENAI_API_KEY:设置OpenAI API密钥。-e OPENAI_PROXY_URL:设置OpenAI代理URL(可选,根据需要配置)。-e ACCESS_CODE:设置访问密码,增强安全性。--name lobe-chat:指定容器名称。 创建完成后,您可以在宝塔面板的Docker管理器中看到LobeChat的容器运行状态。

3. 配置端口和环境变量

确保在创建容器时端口映射为3210:3210,并正确填写上述环境变量。环境变量的配置对于LobeChat的正常运行至关重要,尤其是API Key的设置。

完成这些步骤后,您的LobeChat私有聊天机器人就成功部署了!?

访问部署好的 LobeChat 项目

要访问您部署好的LobeChat项目,只需在浏览器中输入您的服务器地址加上端口号,例如:

http://你的服务器IP:3210这样,您就可以看到LobeChat的用户界面,开始与机器人进行互动了!? 若绑定了域名,则可以使用域名进行访问,具体步骤详见下文。

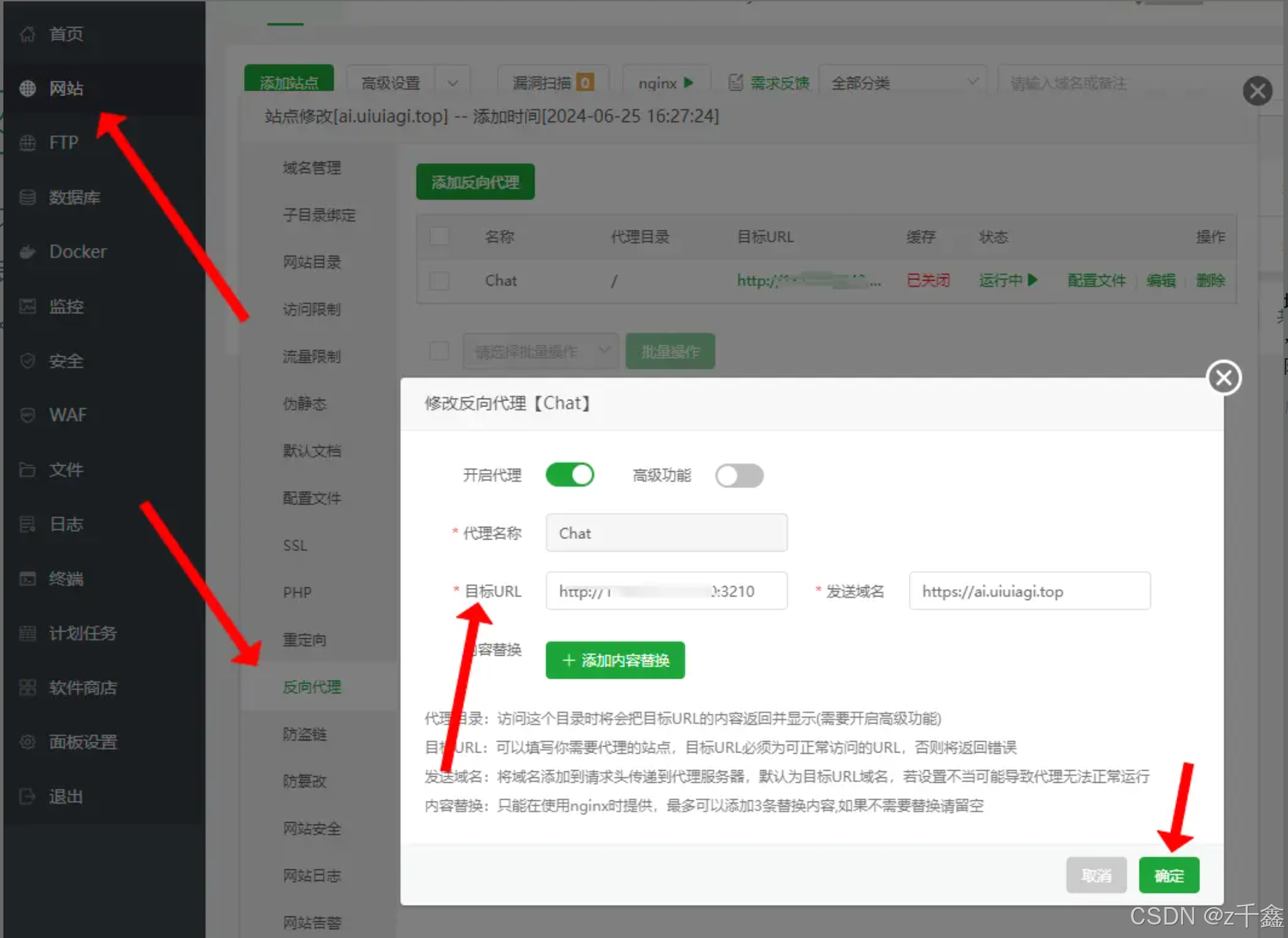

绑定域名

访问在宝塔面板绑定你的域名,域名最好开启SSL访问。

设置返代;

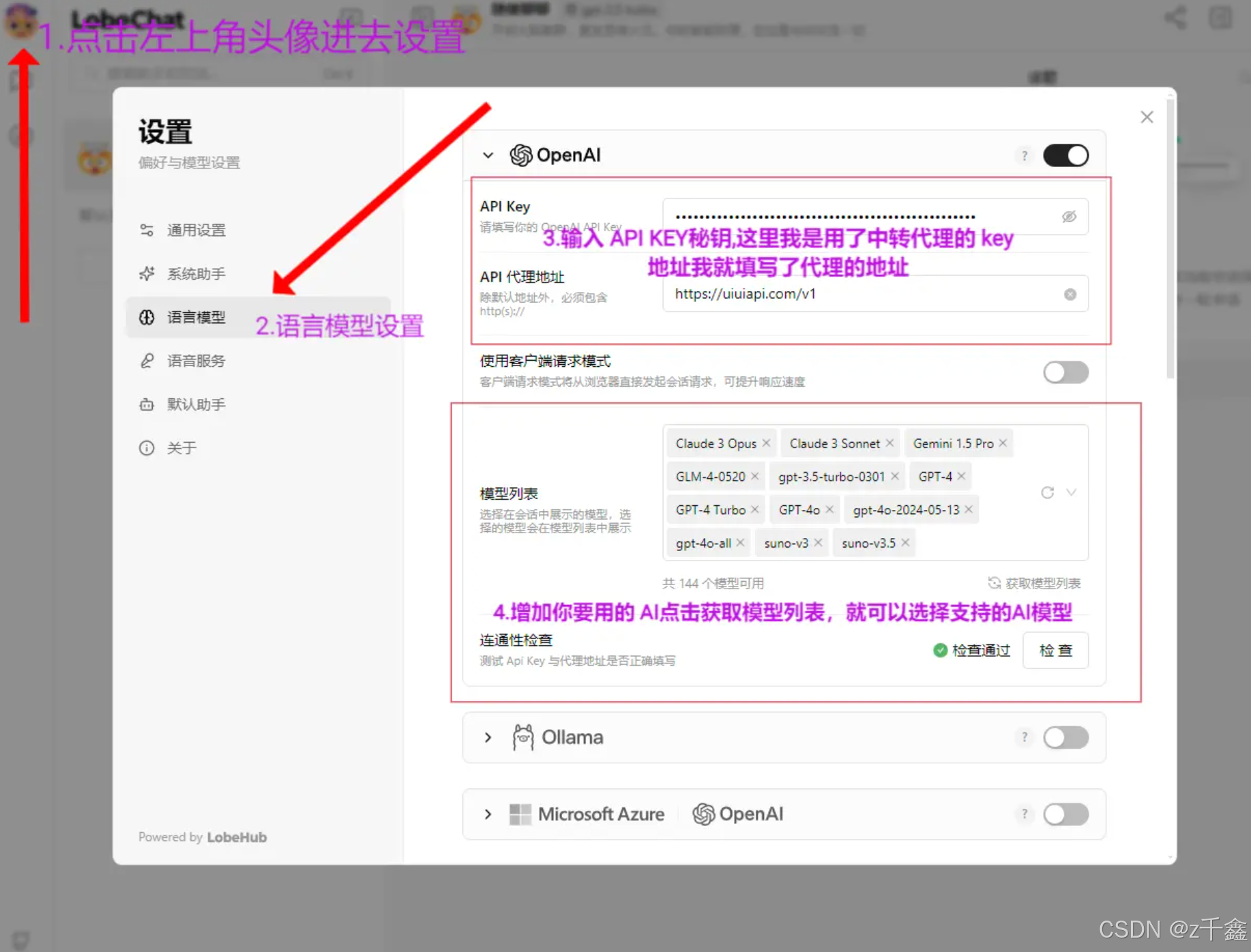

LobeChat 应用设置 API Key

在访问您的LobeChat之前,您需要进行一些基本的应用设置:

登录 LobeChat:使用您在创建Docker容器时设置的ACCESS_CODE进行登录。点击左上角的头像,选择“应用设置”。在“语言模型”中设置相关的API Key、API地址和AI模型选择: API Key:输入您从OpenAI或其他AI提供商获取的API密钥。API地址:根据需要配置API的访问地址。AI模型选择:选择您希望集成的AI模型,如ChatGPT、Claude3等。 保存设置,返回主界面,即可开始使用AI聊天功能。

获取 OpenAI API Key

如果您还没有OpenAI的API Key,可以按照以下步骤获取:

【OpenAI】第一节(OpenAI API)获取OpenAI API KEY的两种方式,开发者必看全方面教程!

LobeChat 项目介绍

LobeChat是一个现代设计的开源LLMs/AI聊天框架,支持多个AI提供商(如OpenAI、Claude3、Gemini等)和多模态功能(如视觉、TTS)。它提供了丰富的插件系统,用户可以轻松部署和管理自己的聊天应用,并根据个人喜好自定义主题和设置。

主要特点:

多模型支持:整合多种AI大模型,提供丰富的对话选择。插件系统:通过插件扩展功能,提升应用的实用性和灵活性。多模态功能:支持语音、图像等多种交互形式,提升用户体验。自定义部署:支持本地和第三方模型的集成,满足不同用户需求。

LobeChat 详细功能介绍

1. 多模型服务提供商支持

LobeChat支持多种模型服务提供商,满足社区的多样化需求,提供更丰富的对话选择。

AWS Bedrock:集成了AWS Bedrock服务,支持Claude和LLama2模型。Anthropic (Claude):接入Claude系列模型,支持突破性的多模态能力。Google AI (Gemini):支持高级语言理解和生成,提升对话质量。OpenAI (ChatGPT):集成OpenAI的ChatGPT模型,享受领先的语言生成能力。

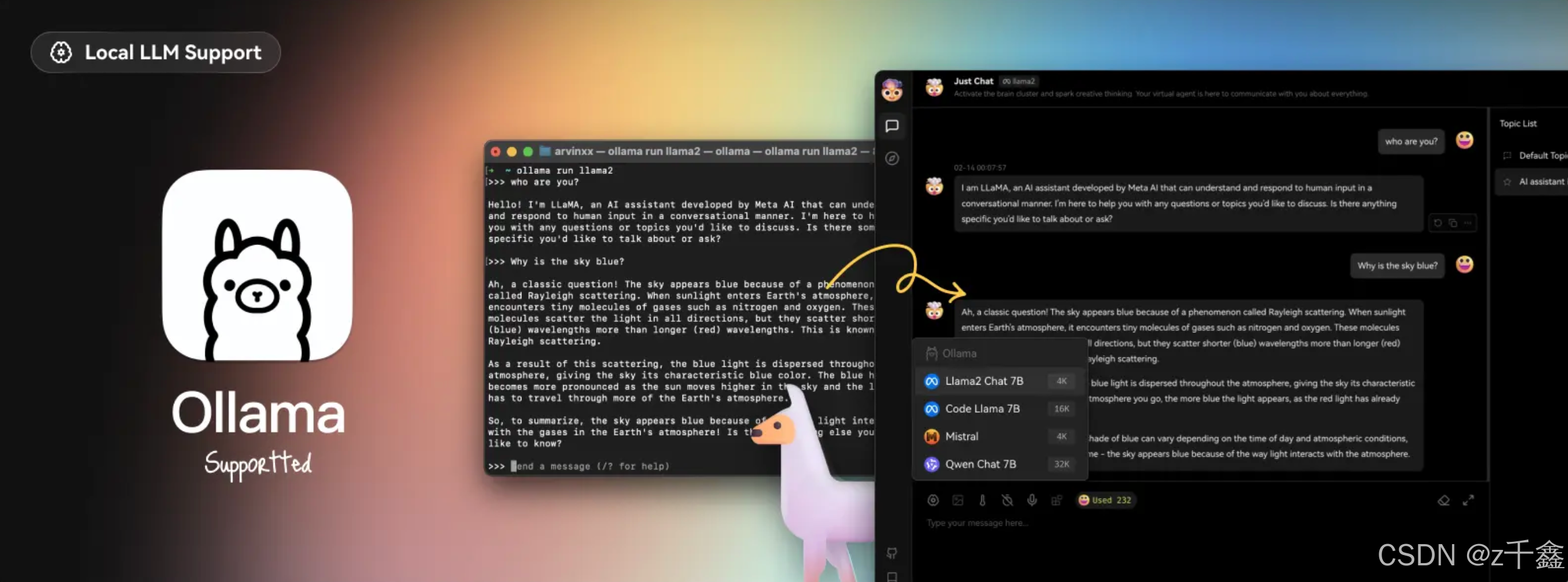

2. 本地大语言模型支持

LobeChat支持基于Ollama的本地模型使用,用户可以灵活使用自己的或第三方模型,保障数据隐私和安全。

3. 模型视觉识别

支持OpenAI的GPT-4-vision模型,可以识别图像内容并进行智能对话,为用户提供更丰富的交互体验。

4. 文本转语音和语音转文本(TTS & STT)

TTS(Text-to-Speech):将文本消息转换为清晰的语音输出,提升交互的自然性。STT(Speech-to-Text):将语音转换为文本,方便用户通过语音进行输入。

5. 文本生成图像

支持DALL-E 3、MidJourney等文本生成图像工具,用户可以在对话中生成高质量的图片,丰富沟通内容。

6. 插件系统

LobeChat提供插件市场,用户可以发现和分享设计良好的插件,支持多语言版本。插件系统支持函数调用,允许核心功能进一步延展,例如:

网页搜索插件:实时获取最新新闻和信息。数据获取插件:从B站、Steam等流媒体平台获取数据。第三方服务交互插件:与各类第三方服务进行数据交互和功能调用。

7. 支持本地/远程数据库

本地数据库:适用于需要更多数据控制和隐私保护的用户,支持SQLite等本地数据库。服务器端数据库:支持PostgreSQL,提供更方便的用户体验和数据管理。

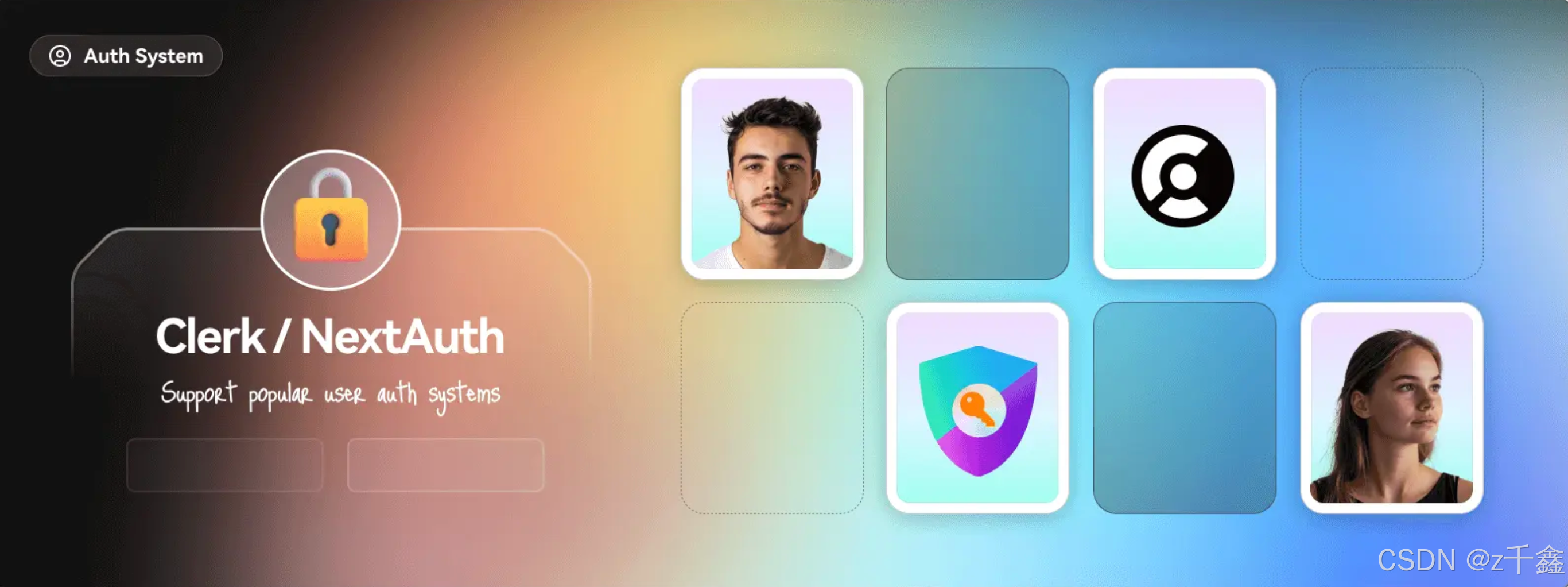

8. 多用户管理

支持多种身份验证方法,包括OAuth、邮件登录等,便于多用户环境下的管理和使用。

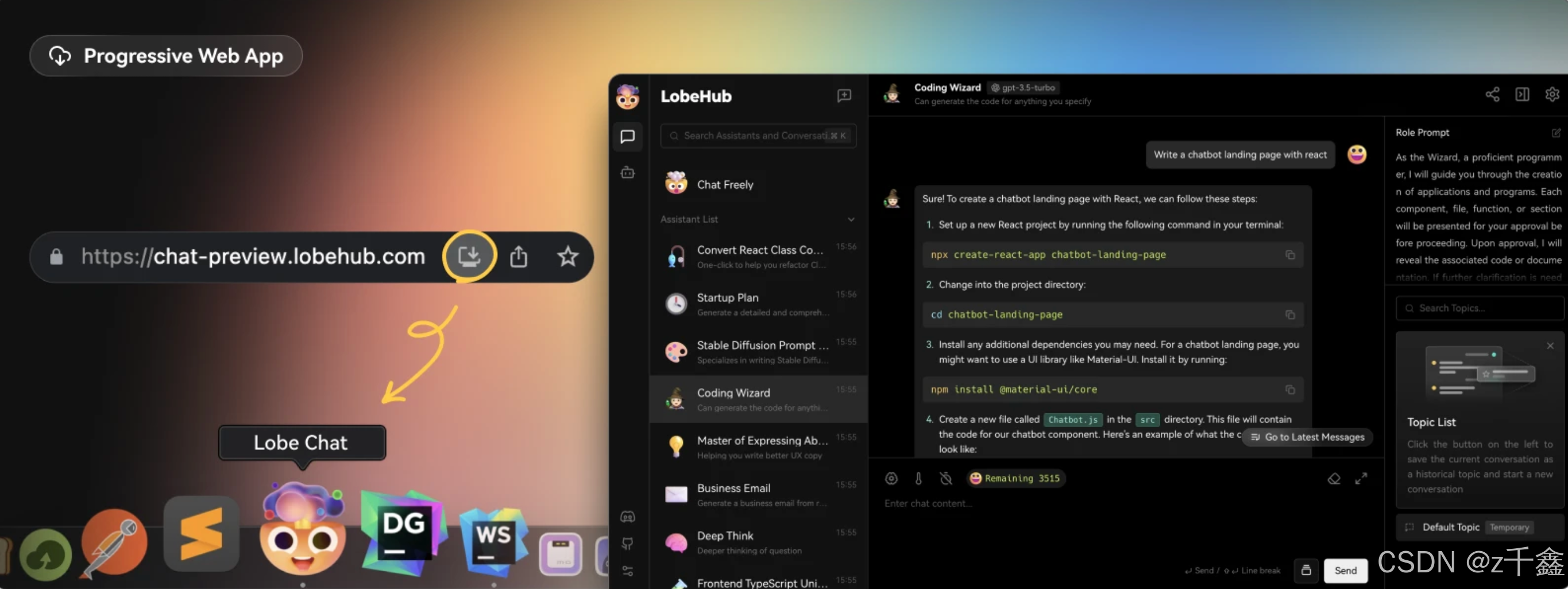

9. 渐进式Web应用(PWA)

提供接近原生应用的体验,支持桌面和移动设备的高度优化用户体验,使得LobeChat在各种设备上使用流畅。

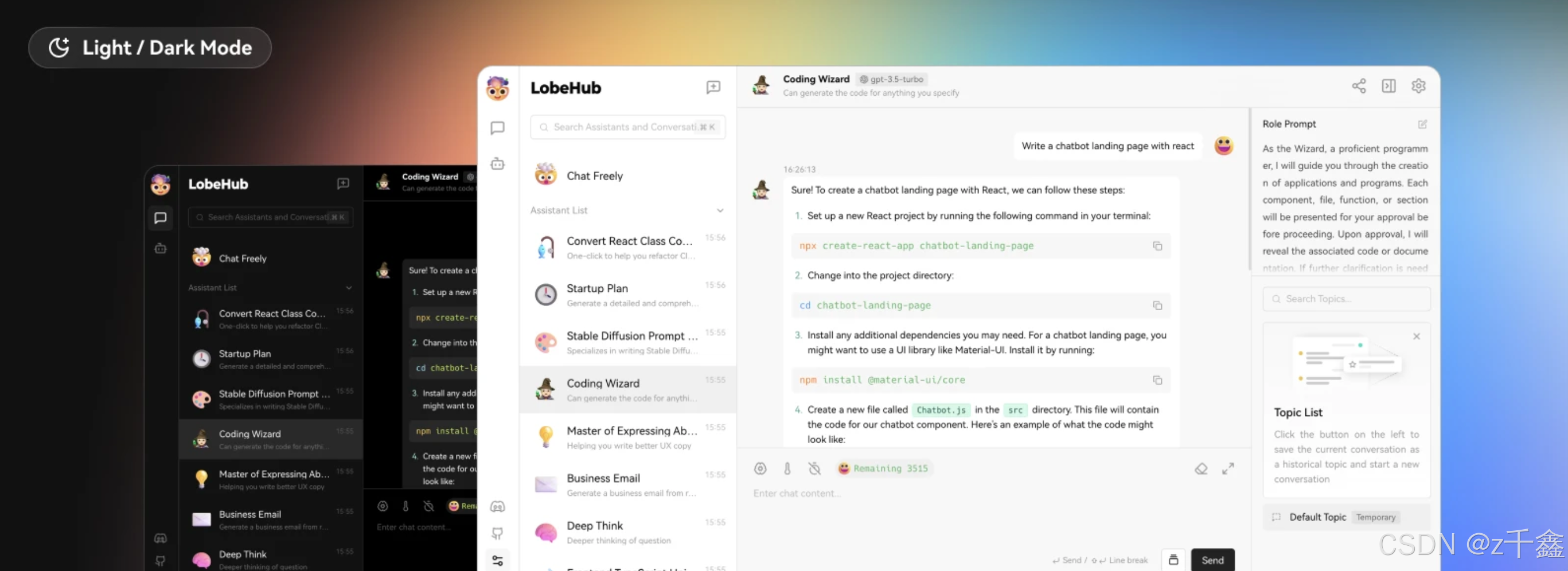

10. 自定义主题

提供灵活多样的主题模式和颜色自定义选项,支持智能识别系统颜色模式,满足不同用户的个性化需求。

总结

通过本文的详细介绍和步骤指南,您已经掌握了如何在宝塔面板上部署LobeChat,打造属于自己的多AI整合平台。无论是个人使用还是企业应用,LobeChat都能为您提供强大的支持和便利的管理体验。LobeChat的开源特性和丰富的功能,使其成为当前AI聊天框架中的佼佼者。希望这篇教程对您有所帮助,快去体验并定制您的专属聊天机器人吧!?