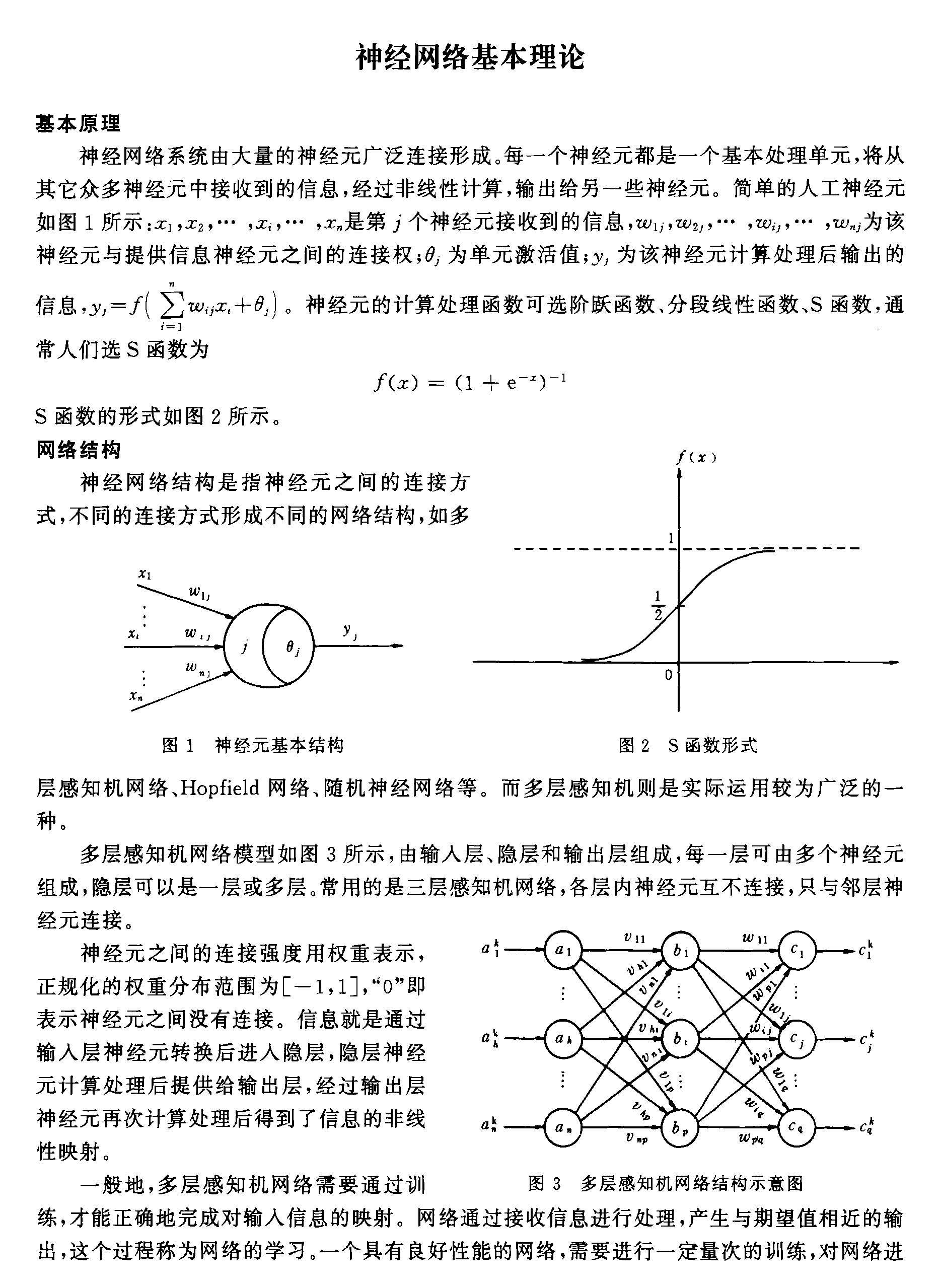

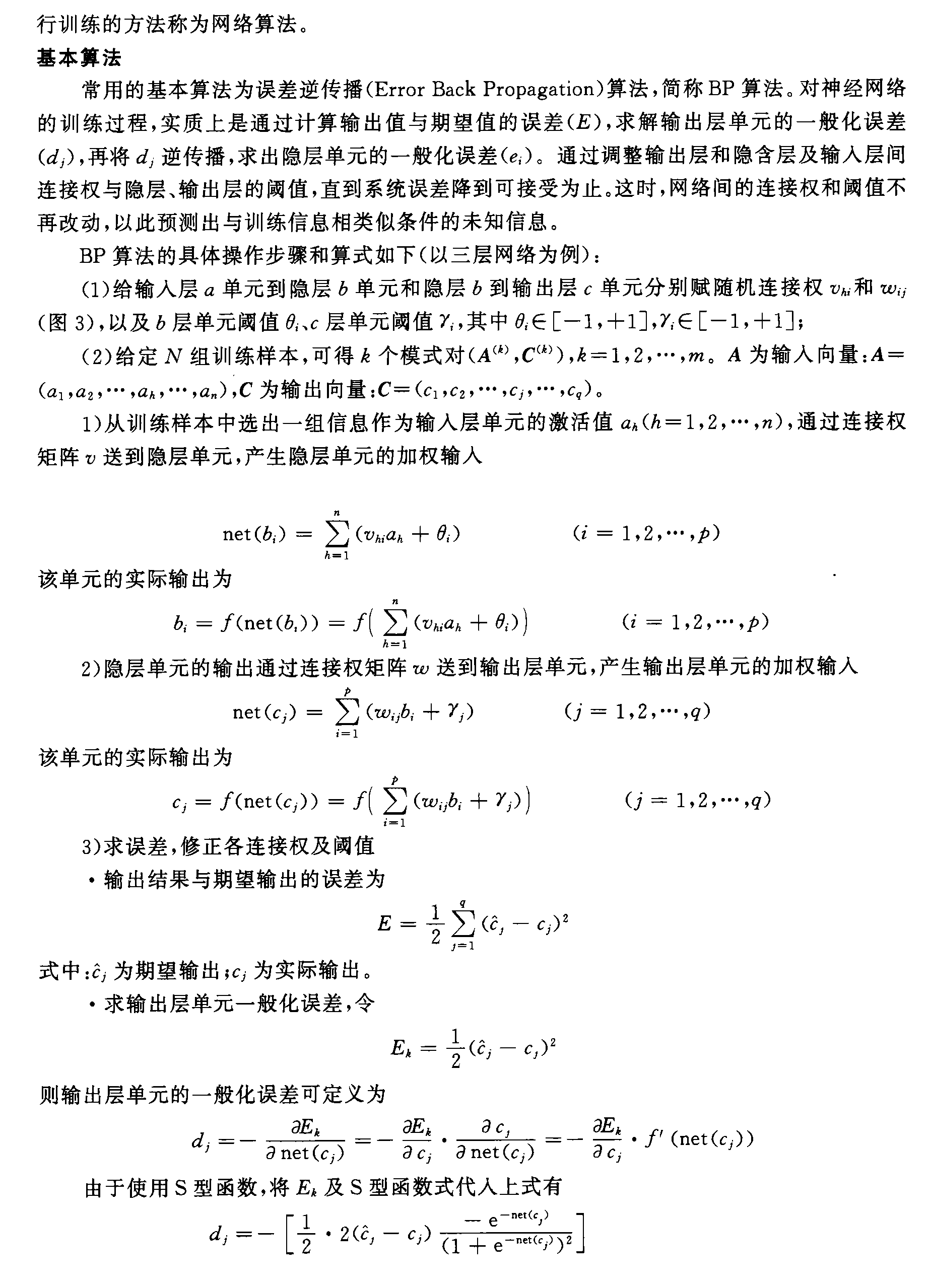

对于很多刚入门的小伙伴来说,神经网络可能比较陌生。神经网络其实是对人认知物体的一种仿真。比如幼儿园老师再教小朋友认动物的时候,会让记住一些特征:比如兔子有长长的耳朵,爱吃萝卜和青菜.........,神经网络也是这样通过构建特征值之间的关系来预测一个较为可靠的结果,更值得一提的是BP神经网络因为有隐藏层的存在所以对于处理复杂的非线性的关系更加准确。目前的神经网络发展到了许多种,在这里我们先介绍一种较为基础和经典的BP神经网络。

一>BP神经网络的原理

上部分内容是比较学术的对BP神经网络的介绍,也让我们了解了BP神经网络的工作原理是误差的正向和反向传递,将正向算出来的误差反向的退还回去,从而使误差慢慢的减小。

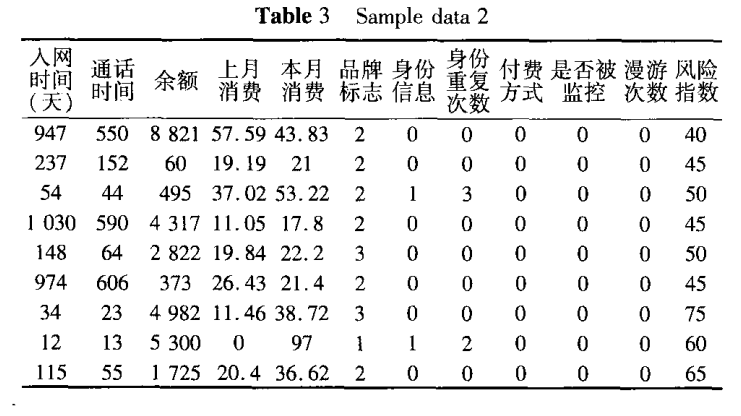

二>BP神经网络的搭建,下面针对漫游用户实时信用度测评及欠费风险超前控制的实验数据(table3)来搭建一个神经网络

(样本数据mat文件我放在百度网盘里了链接:https://pan.baidu.com/s/1Siy4ADM9UWucvCsZwSb2zA?pwd=v5x3 提取码:v5x3 )

产生训练集和测试集

训练集和测试集都是来源于样本。训练集是用来调试神经网络使其找到各特征值合适的预测关系,一般占样本数量的2/3,对表中的9个数据来说取训练集的数量为6。而测试集是用来测试这个得到的预测关系(即神经网络)是否符合实际情况,一般占样本数量的1/3,对表中的9个数据来说取测试集的数量为3。

数据预处理

通常输人数据在各个字段的数值范围 上不可避免地存在差异 。当数值差别很大甚至存在量级的差别时 ,网络受到各种特征的影响不一 。数值大的特征输人将更多地影响网络的学习 这导致网络学习速度变慢甚至不能收敛 。因此对输人数据即训练样本数据的预处理就显得很有必要。即进行训练数据的归一化或称规格化处理 ,以利于不同类别模式样本的统一分析获得更好的学习效率和预测准确性 。

确定神经网络各项参数

隐含层层数:可以为多层,但目前是入门所以设置一层隐藏层数。

隐藏层节点数:节点数不宜过多或过少。如果数目太少,网络将不能建立复杂的判断界,训练不出合适的网络,不能识别以前没有看过的样本,容错性差,但数目过大,就会使训练时间过长,网络的泛化能力降低,而且误差也不一定最佳,因此存在一个最佳的隐藏层节点数.确定隐含层节点数的基本原则使:在满足精度的前提下,取尽可能紧凑的结构,即取尽可能少的隐含层节点数。确立隐藏节点的公式为:节点数=log2(输入层节点数)。本案例中隐藏层节点数设置为3。

最大迭代次数(net.trainParam.epochs):最大迭代次数是神经网络计算并不能保证在各种参数配置下迭代结果收敛,当迭代结果不收敛时,允许最大的迭代次数。

允许误差(net.trainParam.goal):允许误差是指当2次迭代结果的误差小于该值时,系统结束循环。一般取0.001~0.00001。

学习速率(net.trainParam.lr):BP算法中,训练速率是由经验确定,训练速率越大,权重变化越大,收敛越快;但训练速率过大,会引起系统的振荡,因此,训练速率在不导致振荡前提下,越大越好。本案例取学习率为0.9。

神经网络的训练与仿真

这一步可以直接用matlab里内置的函数train和sim实现。

神经网络评价

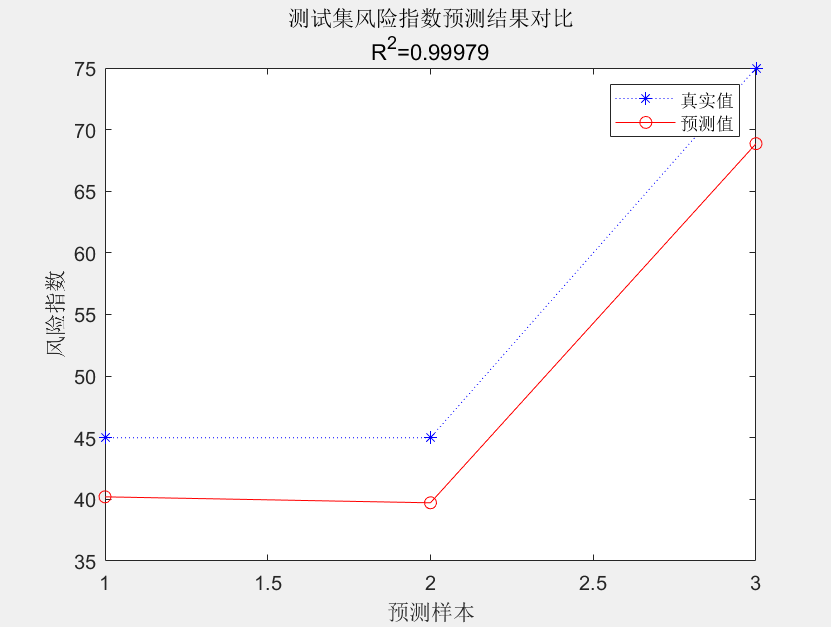

对于已经经过训练的神经网络怎样来评价其性能好坏呢?可以计算预测值和真实值之间的相对误差。相对误差越小,表明模型的性能越好。决定系数范围在[0,1]内,越接近于1,表明模型的拟合性能越好,反之,越趋近于0,表明模型的拟合性能越差。本案例训练出的神经网络,最后预测值和真实值的相对误差R^2=0.99979,说明模拟效果较为良好。

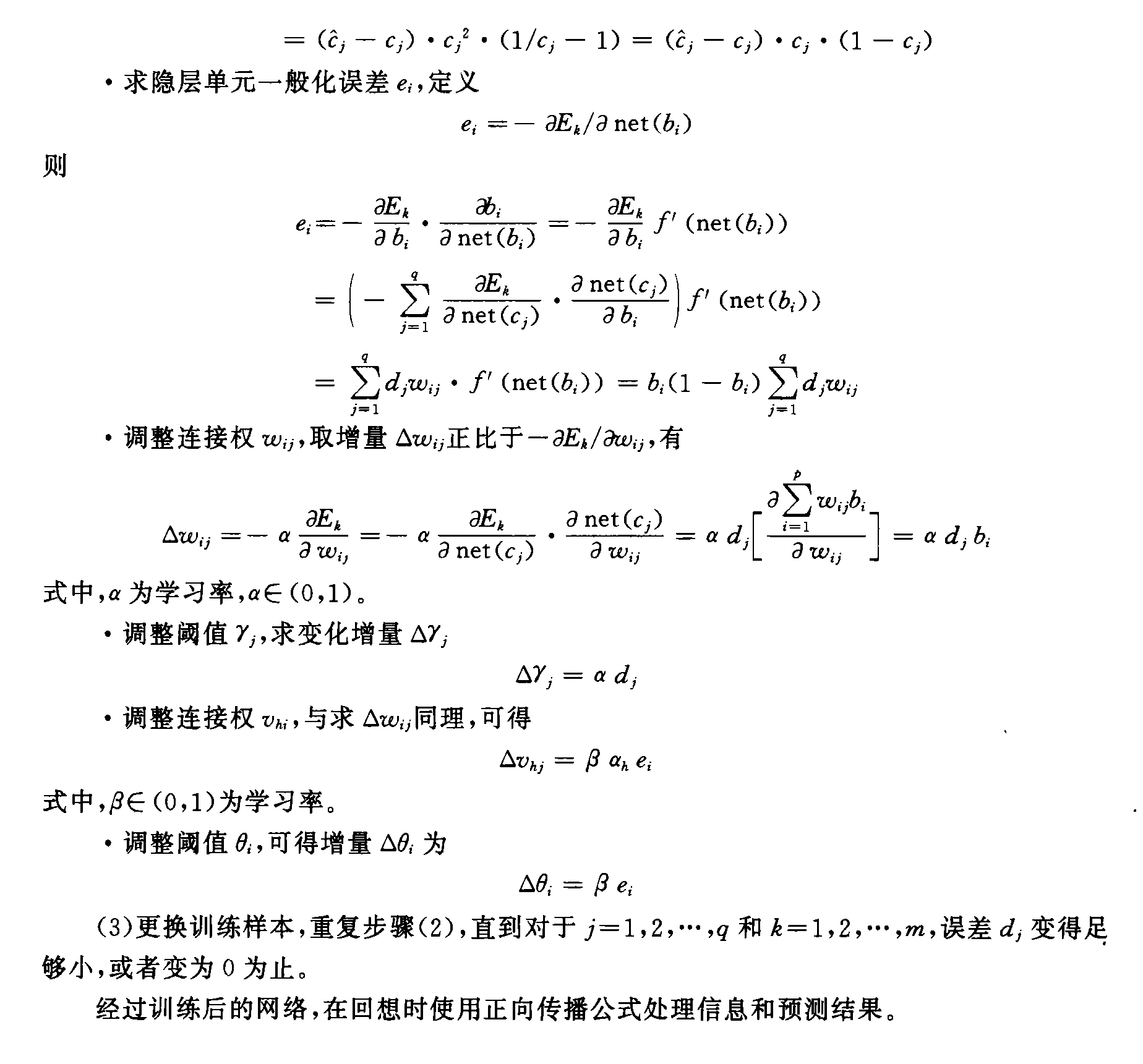

三>代码实现

%% I. 清空环境变量clcclear allload roam-data.mat%%%%%%% 2. 随机产生训练集和测试集temp = randperm(size(sda,1));%size(a,1)行数,size(aa,2)列数产生1:60随机数列% 训练集——50个样本P_train = sda(temp(1:6),:)';%单引号矩阵转置,50组随机数据,列50行401T_train = risdex1(temp(1:6),:)';% 测试集——10个样本P_test = sda(temp(7:end),:)';T_test = risdex1(temp(7:end),:)';N = size(P_test,2);%=10,列数,10组数据%% III. 数据归一化[p_train, ps_input] = mapminmax(P_train,0,1);%归一化训练数据p_test = mapminmax('apply',P_test,ps_input);%测试数据同样规则归一化[t_train, ps_output] = mapminmax(T_train,0,1);%% IV. BP神经网络创建、训练及仿真测试%%% 1. 创建网络net = newff(p_train,t_train,3);%P:输入参数矩阵。(RxQ1),其中Q1代表R元的输入向量。%S:N-1个隐含层的数目(S(i)到S(N-1)%%% 2. 设置训练参数net.trainParam.epochs = 1000;% 训练次数net.trainParam.goal = 1e-3;%训练目标最小误差net.trainParam.lr = 0.9;%学习率%%% 3. 训练网络net = train(net,p_train,t_train);%%% 4. 仿真测试t_sim = sim(net,p_test);%%% 5. 数据反归一化T_sim = mapminmax('reverse',t_sim,ps_output);%% V. 性能评价%%% 1. 相对误差errorerror = abs(T_sim - T_test)./T_test;%%% 2. 决定系数R^2R2 = (N * sum(T_sim .* T_test) - sum(T_sim) * sum(T_test))^2 / ((N * sum((T_sim).^2) - (sum(T_sim))^2) * (N * sum((T_test).^2) - (sum(T_test))^2)); %%% 3. 结果对比result = [T_test' T_sim' error']%% VI. 绘图figureplot(1:N,T_test,'b:*',1:N,T_sim,'r-o')legend('真实值','预测值')xlabel('预测样本')ylabel('风险指数')string = {'测试集风险指数预测结果对比';['R^2=' num2str(R2)]};title(string)

四>结果图