张士玉小黑屋

一个关注IT技术分享,关注互联网的网站,爱分享网络资源,分享学到的知识,分享生活的乐趣。

当前位置:首页 » 《随便一记》 - 第64页

Javaweb | ServletContext对象

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 620次

?wei_shuo的个人主页?wei_shuo的学习社区?HelloWorld!ServletContext对象概述全局对象,拥有作用域,对应Tomcat的Web应用Web服务器启动时,会为每一个Web应用程序创建一块共享的存储区域(ServletContext)ServletContext在Web服务器启动时创建,服务器关闭时销毁获取ServletContext对象GenericServlet提供getServletContext();方法this.getServletContext();HttpServletRequest提供getServletContext();方法HttpSession提供getServletContext();

springboot整合Minio + vue 实现文件分片上传(完整代码)

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 10139次

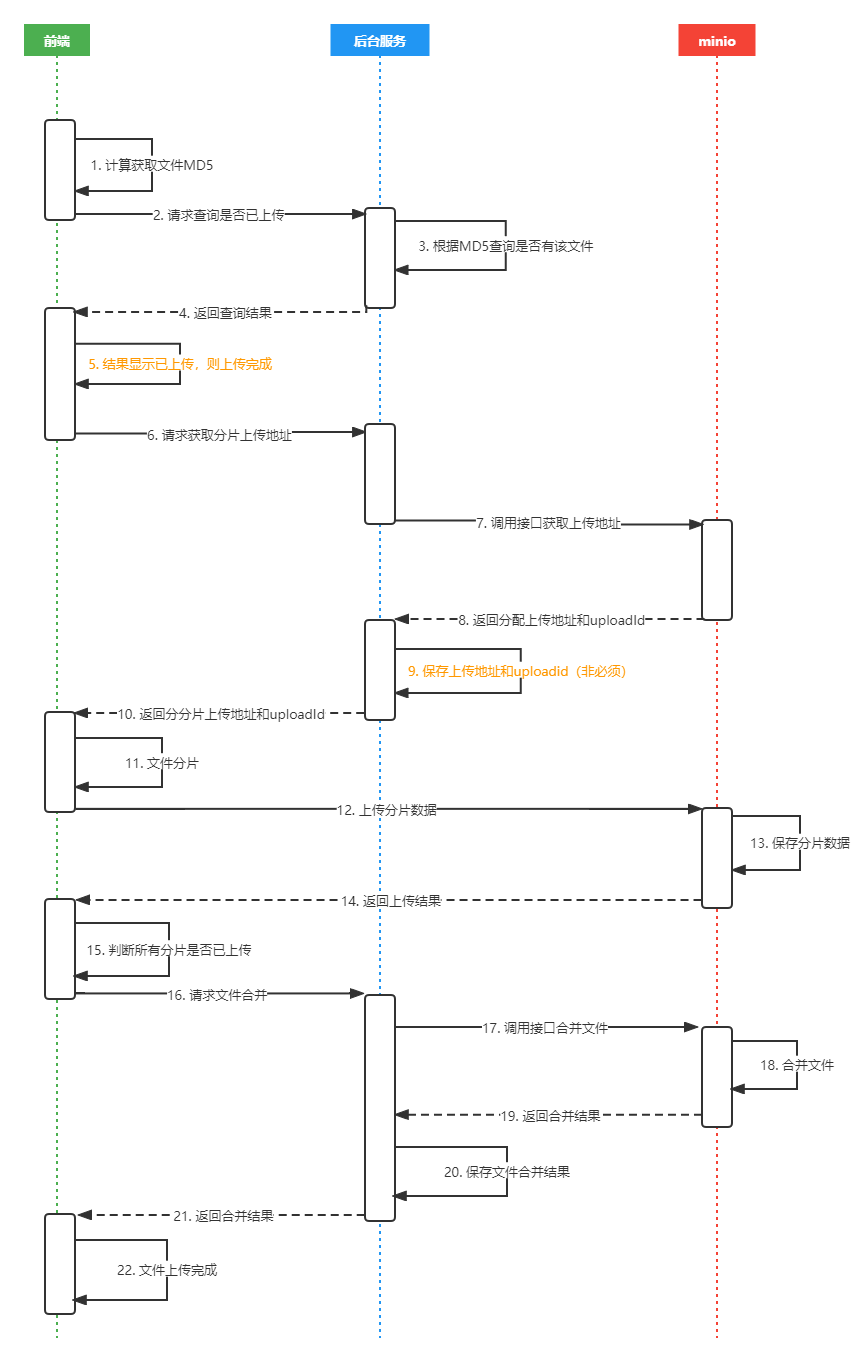

网上关于minio分片上传的资料不太详细,缺斤少两,所以我基于他们的代码做了一些修改,demo能够正常运行起来,但是偶尔也会发生一些小bug,不过这些都无伤大雅,最终目的是理解代码背后的逻辑和流程流程:前端获取生成文件MD5,发送至后台判断是否有该文件缓存,有信息终止上传,无则开始进行文件分片 。这里,我为了简单方便实现便没有使用数据库,直接用redis存储文件信息;前端后端返回的结果进行分片,然后将文件分片的信息传输给后端,后端调用minio初始化,返回分片上传地址和uploadId;前端则根据获取的分片上传地址直接通过axios上传分片文件,不走后端;上传完成后,前端发送请求至后端,后端调用minio合并文件;流程图:效果图 1.vue前端2.mini

pycharm怎么改成中文(汉化插件 pycharm自带)

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 499次

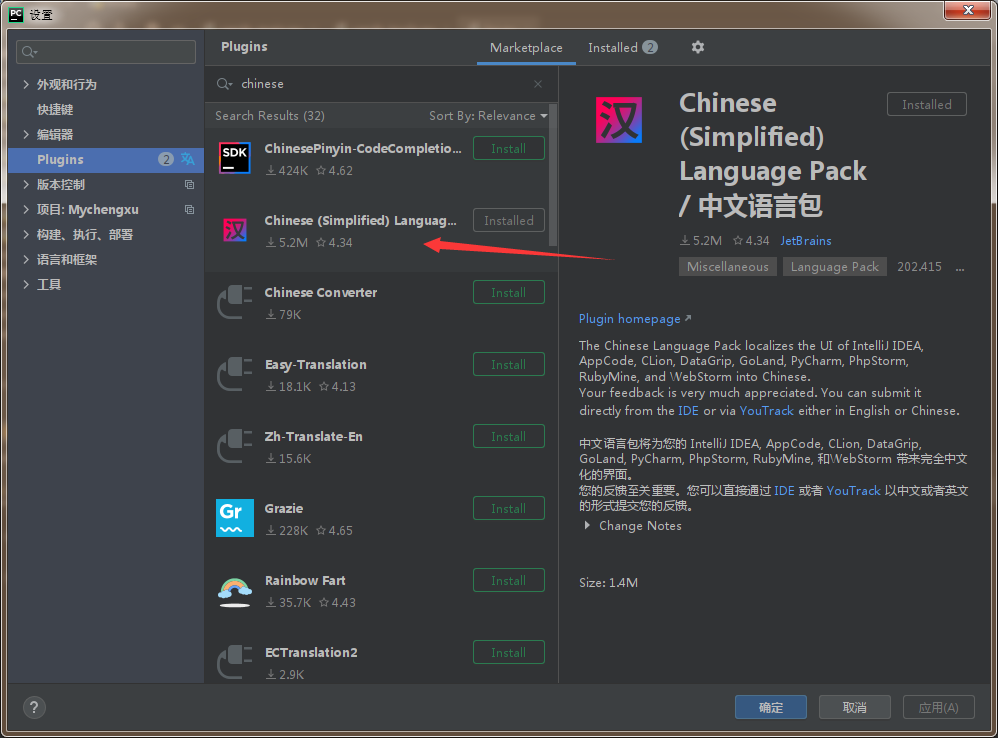

1、打开PyCharm软件,默认显示英文界面2、点击“file”选项,然后点击“setting”,再点击“plugins”选项;3、输入“Chinese”找到中文安装包(第二个),点击“Install”(因为本人的pycharm已经汉化,界面有所不同)4、安装完成后,点击“restartIDE”重启程序。(重启后的界面已经更改为中文)拓展:使用同样的方法可以安装其他常用的插件;1.chinese(Simplified)LanguagePack/中文语言包(汉化插件)2.activate-power-mode码代码也就装逼点3.Translation翻译插件超赞4.RainbowBrackets让括号有不同颜色舒服5.JSONParser搞爬虫的做

<数据结构> 链表 - 单链表(c语言实现)

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 406次

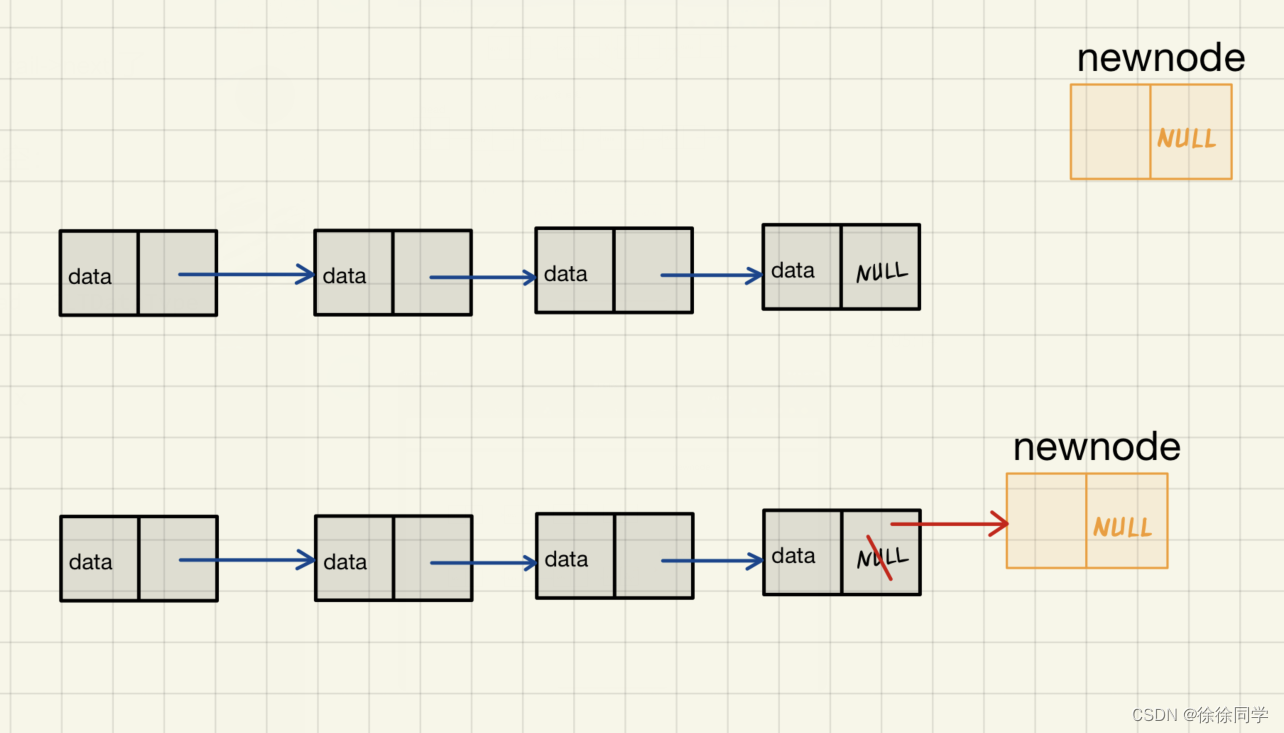

B.最简单结构的链表——不带哨兵位单链表的实现(关于哨兵位结点)一、不带哨兵位单链表结点的创建1.1typedef链表的数据类型1.2结点的结构体创建二、单链表要实现的功能三、需要包含的头文件四、函数接口一览为什么有些函数参数传递的是二级指针,有些是一级指针?五、功能的实现1)打印单链表2)创建新节点3)尾插4)尾删5)头插6)头删7)查找8)删除9)插入结点10)销毁(关于哨兵位结点)哨兵位结点也叫哑节点。哨兵位结点也是头结点。该节点不存储有效数据,只是为了方便操作(如尾插时用带哨兵位的头结点很爽,不需要判空)。有哨兵位结点的链表,第一个元素应该是链表第二个节点(head->next,head为哨

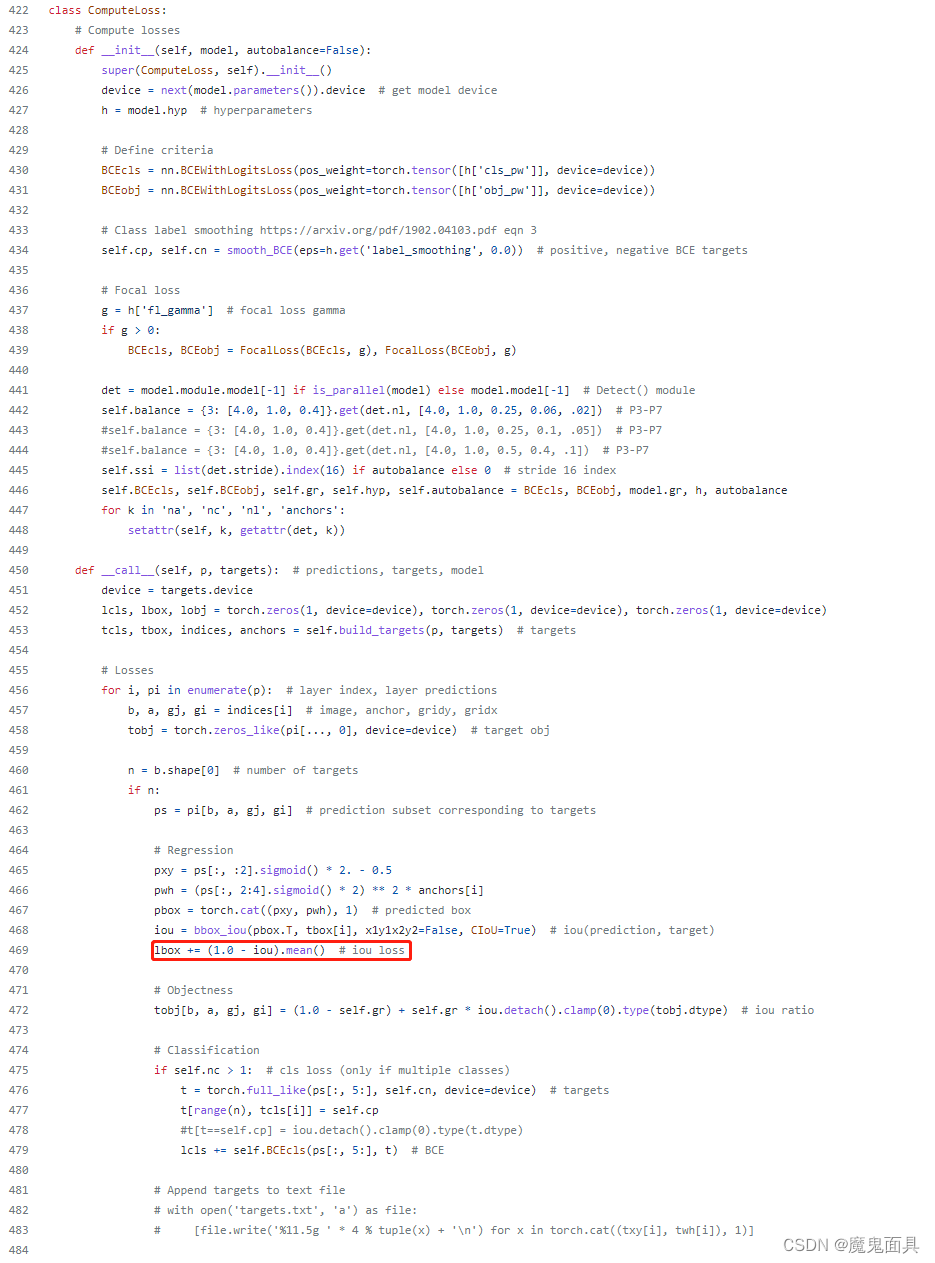

YOLOV7改进-添加EIoU,SIoU,AlphaIoU,FocalEIoU,Wise-IoU

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 396次

在YoloV7中添加EIoU,SIoU,AlphaIoU,FocalEIoU,Wise-IoU.yolov7中box_iou其默认用的是CIoU,其中代码还带有GIoU,DIoU,AlphaIoU,文件路径:utils/general.py,函数名为:bbox_iou重磅!!!!!YOLO模型改进集合指南-CSDNdefbbox_iou(box1,box2,x1y1x2y2=True,GIoU=False,DIoU=False,CIoU=False,eps=1e-7):#ReturnstheIoUofbox1tobox2.box1is4,box2isnx4box2=box2.T#Getthecoordinat

足够惊艳,使用Alpaca-Lora基于LLaMA(7B)二十分钟完成微调,效果比肩斯坦福羊驼

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 570次

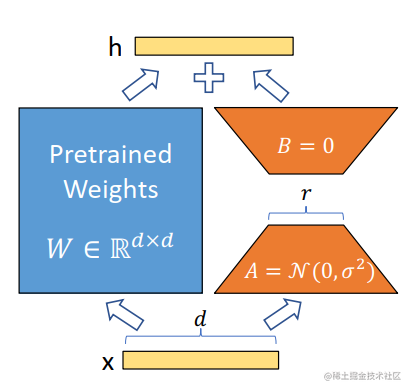

之前尝试了从0到1复现斯坦福羊驼(StanfordAlpaca7B),StanfordAlpaca是在LLaMA整个模型上微调,即对预训练模型中的所有参数都进行微调(fullfine-tuning)。但该方法对于硬件成本要求仍然偏高且训练低效。因此,Alpaca-Lora则是利用Lora技术,在冻结原模型LLaMA参数的情况下,通过往模型中加入额外的网络层,并只训练这些新增的网络层参数。由于这些新增参数数量较少,这样不仅微调的成本显著下降(使用一块RTX4090显卡,只用5个小时就训练了一个与Alpaca水平相当的模型,将这类模型对算力的需求降到了消费级),还能获得和全模型微调(fullfine-tuning)类似的效果。LoRA技术原理L

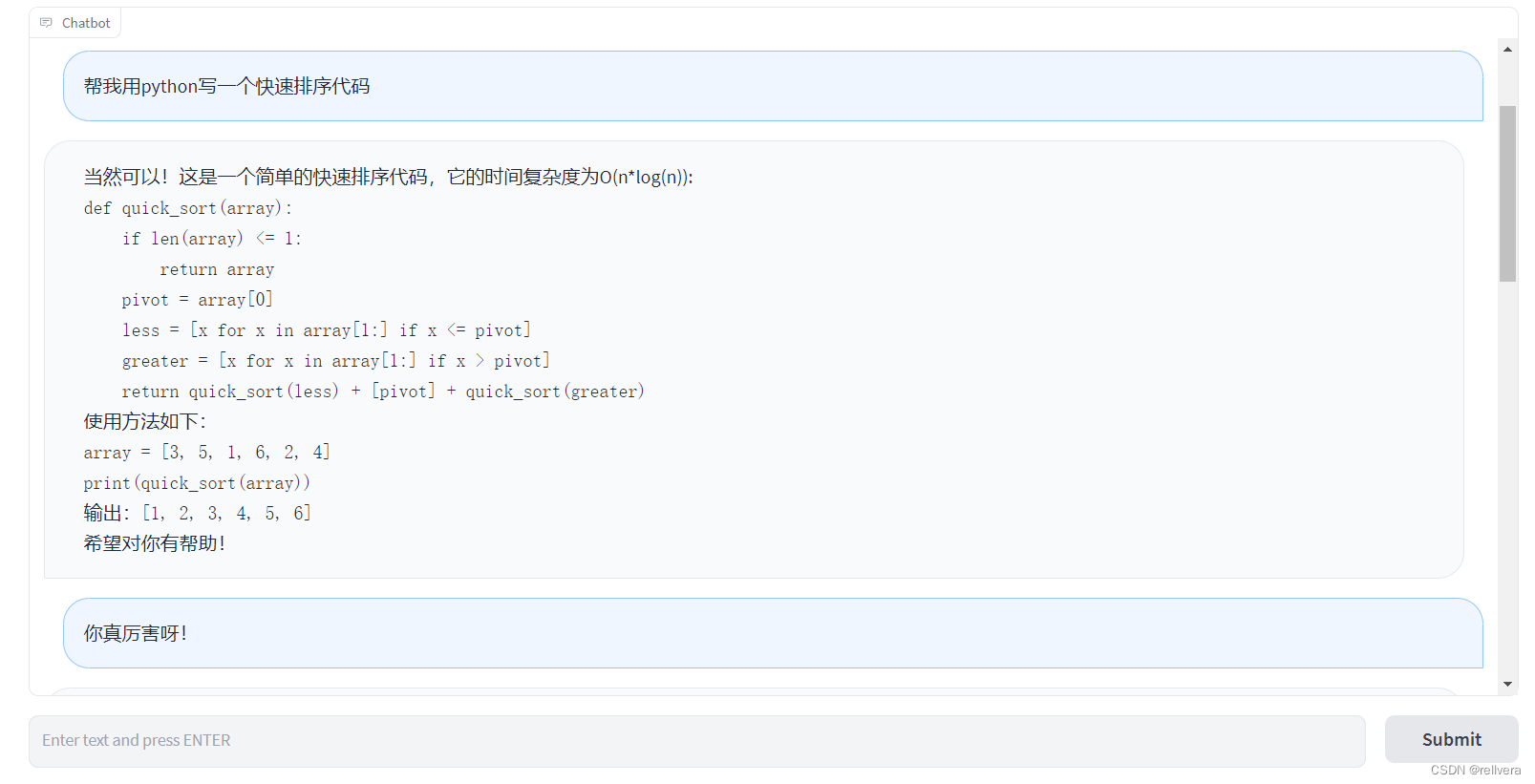

开源模型:小羊驼(Vicuna-13B),可达chatGPT九成效果。

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 377次

参考链接:https://mp.weixin.qq.com/s/OK5NLLVSBLb-4QsnqGp45g文章目录简要介绍模型介绍数据来源模型评估方法模型局限性模型总体评价简要介绍以Meta开源LLaMA(直译为「大羊驼」)系列模型为起点,研究人员逐渐研发出基于LLaMA的Alpaca(羊驼)、Alpaca-Lora、Luotuo(骆驼)等轻量级类ChatGPT模型并开源。近日,研究者们又提出了一个新的模型:Vicuna(小羊驼)。该模型基于LLaMA,参数量13B。Vicuna-13B就是通过微调LLaMA实现了高性能的对话生成有趣的是,在该模型的评测环节中,作者没有通过某种“标准化考试”来测定模型性能,而是让GPT-4当考官,看看GPT-

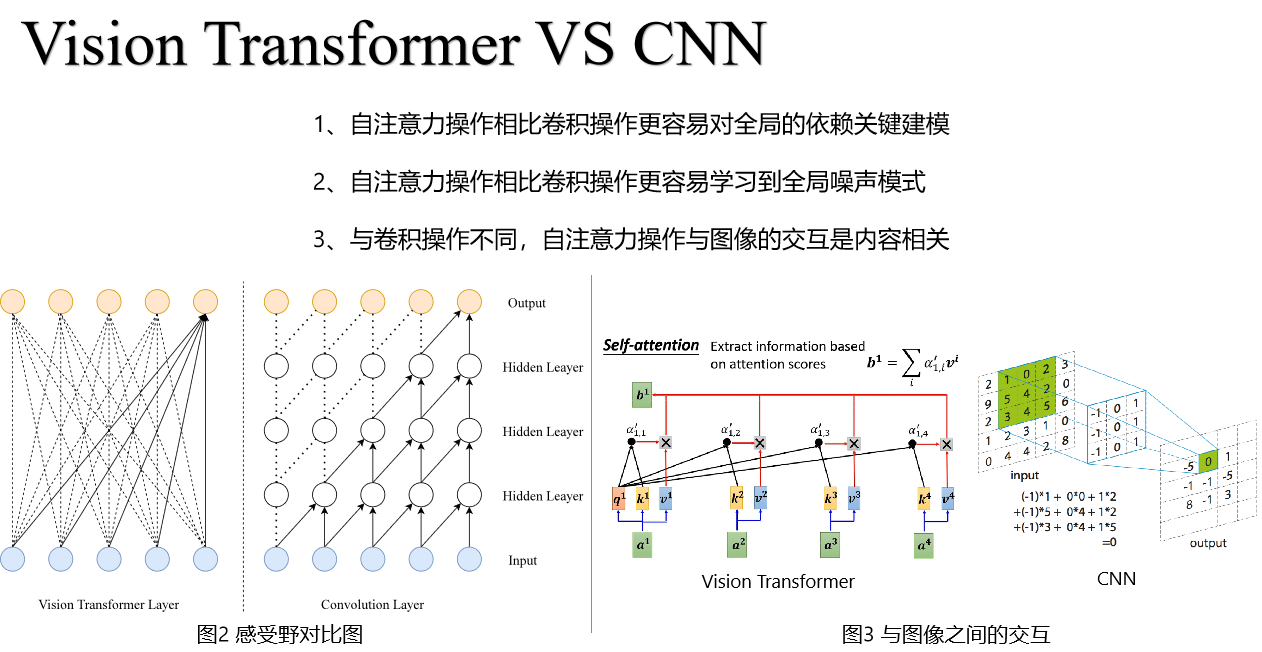

基于Vision Transformer的图像去雾算法研究与实现(附源码)

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 621次

基于VisionTransformer的图像去雾算法研究与实现0.服务器性能简单监控\LOG_USE_CPU_MEMORY\文件夹下的use_memory.py文件可以实时输出CPU使用率以及内存使用率,配合nvidia-smi监控GPU使用率可以了解服务器性能是否足够;运行时在哪一步使用率突然升高;是否需要释放内存等等1.数据集1.1NH-HAZE数据集下载:https://competitions.codalab.org/competitions/22236#participate-get_dataTrain:1-40;Test:41-45我们引入了NH-HAZE,一个非均匀的真实数据集,有成对真实的模糊和相应的无雾图像。因此,非均匀雾霾数据集的存在对于图

Pytorch 基于ResNet-18的服饰识别(使用Fashion-MNIST数据集)

发布 : zsy861 | 分类 : 《随便一记》 | 评论 : 0 | 浏览 : 377次

✅作者简介:人工智能专业本科在读,喜欢计算机与编程,写博客记录自己的学习历程。?个人主页:小嗷犬的博客?个人信条:为天地立心,为生民立命,为往圣继绝学,为万世开太平。?本文内容:Pytorch基于ResNet-18的服饰识别(使用Fashion-MNIST数据集)更多内容请见?Pytorch基于AlexNet的服饰识别(使用Fashion-MNIST数据集)Pytorch基于VGG-16的服饰识别(使用Fashion-MNIST数据集)Pytorch基于NiN的服饰识别(使用Fashion-MNIST数据集)本文目录介绍1.导入相关库2.定义ResNet-18网络结构3.下载并配置数据集和加载器4.定义训练函数5.训练模型(或加载模型)6.可视化展

Copyright © 2020-2022 ZhangShiYu.com Rights Reserved.豫ICP备2022013469号-1